Os deepfakes de vídeo significam que você não pode confiar em tudo o que vê. Agora, deepfakes de áudio podem significar que você não pode mais confiar em seus ouvidos. Era realmente o presidente declarando guerra ao Canadá? É realmente seu pai no telefone pedindo a senha do e-mail dele?

Acrescente outra preocupação existencial à lista de como nossa própria arrogância pode inevitavelmente nos destruir. Durante a era Reagan, os únicos riscos tecnológicos reais eram a ameaça de guerra nuclear, química e biológica.

Nos anos seguintes, tivemos a oportunidade de ficar obcecados com a gosma cinza da nanotecnologia e as pandemias globais. Agora, temos deepfakes - pessoas perdendo o controle sobre sua imagem ou voz.

O que é um Deepfake de áudio?

A maioria de nós viu um vídeo deepfake , em que algoritmos de aprendizado profundo são usados para substituir uma pessoa pela semelhança de outra. Os melhores são irritantemente realistas e agora é a vez do áudio. Um deepfake de áudio é quando uma voz "clonada" que é potencialmente indistinguível da de uma pessoa real é usada para produzir áudio sintético.

“É como o Photoshop para voz”, disse Zohaib Ahmed, CEO da Assemelha-se a AI , sobre a tecnologia de clonagem de voz de sua empresa.

No entanto, trabalhos ruins do Photoshop são facilmente desmascarados. Uma empresa de segurança com a qual falamos disse que as pessoas normalmente só adivinham se um deepfake de áudio é real ou falso com cerca de 57 por cento de precisão - nada melhor do que um cara ou coroa.

Além disso, como muitas gravações de voz são de chamadas telefônicas de baixa qualidade (ou gravadas em locais barulhentos), os deepfakes de áudio podem se tornar ainda mais indistinguíveis. Quanto pior for a qualidade do som, mais difícil será captar aqueles sinais reveladores de que uma voz não é real.

Mas por que alguém precisaria de um Photoshop para vozes, afinal?

O caso atraente para áudio sintético

Na verdade, há uma enorme demanda por áudio sintético. De acordo com Ahmed, “o ROI é muito imediato”.

Isso é particularmente verdadeiro quando se trata de jogos. No passado, a fala era o único componente em um jogo que era impossível de criar sob demanda. Mesmo em títulos interativos com cenas com qualidade de cinema reproduzidas em tempo real, as interações verbais com personagens não jogáveis são sempre essencialmente estáticas.

Agora, porém, a tecnologia foi atualizada. Os estúdios têm o potencial de clonar a voz de um ator e usar mecanismos de conversão de texto em voz para que os personagens possam dizer qualquer coisa em tempo real.

Existem também usos mais tradicionais em publicidade e suporte técnico e ao cliente. Aqui, uma voz que soe autenticamente humana e responda pessoal e contextualmente sem intervenção humana é o que é importante.

As empresas de clonagem de voz também estão entusiasmadas com as aplicações médicas. É claro que a substituição de voz não é novidade na medicina - Stephen Hawking usou uma voz sintetizada robótica depois de perder a sua em 1985. No entanto, a clonagem de voz moderna promete algo ainda melhor.

Em 2008, empresa de voz sintética, CereProc , deu ao falecido crítico de cinema, Roger Ebert, sua voz de volta depois que o câncer a levou embora. O CereProc publicou uma página da web que permitia às pessoas digitar mensagens que seriam faladas na voz do ex-presidente George Bush.

“Ebert viu isso e pensou,‘ bem, se eles puderam copiar a voz de Bush, eles deveriam ser capazes de copiar a minha ”, disse Matthew Aylett, diretor científico do CereProc. Ebert então pediu à empresa que criasse uma voz substituta, o que eles fizeram ao processar uma grande biblioteca de gravações de voz.

“Foi uma das primeiras vezes que alguém fez isso e foi um verdadeiro sucesso”, disse Aylett.

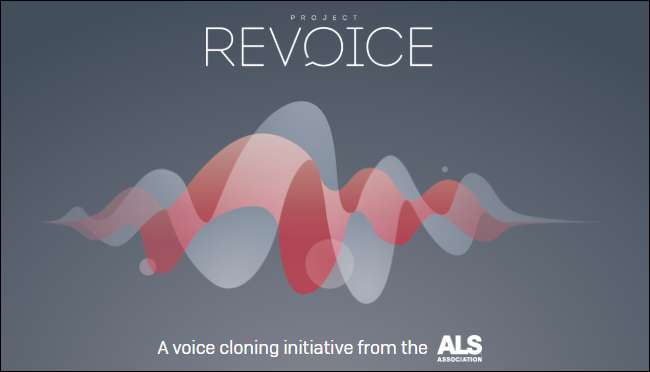

Nos últimos anos, várias empresas (incluindo a CereProc) trabalharam com a Associação ALS em Projeto Revoice para fornecer vozes sintéticas para aqueles que sofrem de ALS.

Como funciona o áudio sintético

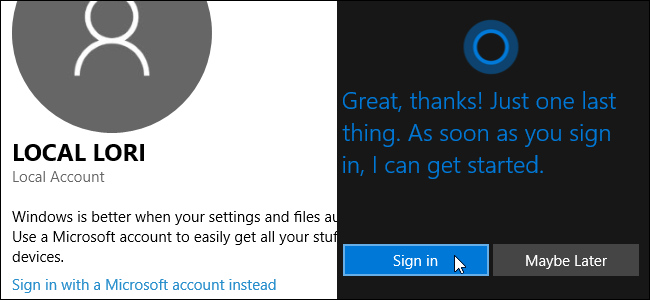

A clonagem de voz está tendo um momento agora, e várias empresas estão desenvolvendo ferramentas. Assemelha-se a AI e Descrição tem demos online que qualquer um pode experimentar gratuitamente. Basta gravar as frases que aparecem na tela e, em poucos minutos, é criado um modelo de sua voz.

Você pode agradecer à IA - especificamente, algoritmos de aprendizagem profunda —Para ser capaz de combinar a fala gravada com o texto para entender os fonemas que compõem sua voz. Em seguida, ele usa os blocos de construção linguísticos resultantes para aproximar palavras que não ouviu você falar.

A tecnologia básica já existe há algum tempo, mas, como Aylett destacou, era necessária alguma ajuda.

“Copiar voz era um pouco como fazer massa”, disse ele. “Foi meio difícil de fazer e havia várias maneiras de ajustá-lo manualmente para fazê-lo funcionar”.

Os desenvolvedores precisavam de enormes quantidades de dados de voz gravados para obter resultados aceitáveis. Então, alguns anos atrás, as comportas se abriram. A pesquisa no campo da visão computacional provou ser crítica. Os cientistas desenvolveram redes adversárias geradoras (GANs), que poderiam, pela primeira vez, extrapolar e fazer previsões com base nos dados existentes.

“Em vez de um computador ver a imagem de um cavalo e dizer 'este é um cavalo', meu modelo agora poderia transformar um cavalo em uma zebra”, disse Aylett. “Então, a explosão na síntese da fala agora é graças ao trabalho acadêmico da visão computacional.”

Uma das maiores inovações na clonagem de voz foi a redução geral da quantidade de dados brutos necessários para criar uma voz. No passado, os sistemas precisavam de dezenas ou mesmo centenas de horas de áudio. Agora, no entanto, vozes competentes podem ser geradas a partir de apenas alguns minutos de conteúdo.

RELACIONADOS: O problema com IA: as máquinas estão aprendendo coisas, mas não conseguem entendê-las

O medo existencial de não confiar em nada

Essa tecnologia, junto com a energia nuclear, nanotecnologia, impressão 3D e CRISPR, é simultaneamente emocionante e aterrorizante. Afinal, já houve casos no noticiário de pessoas sendo enganadas por clones de voz. Em 2019, uma empresa do Reino Unido afirmou que era enganado por um deepfake de áudio telefonema para enviar dinheiro aos criminosos.

Você não precisa ir muito longe para encontrar falsificações de áudio surpreendentemente convincentes. Canal do Youtube Síntese Vocal apresenta pessoas conhecidas dizendo coisas que nunca disseram, como George W. Bush lendo "In Da Club" de 50 Cent . Está no local.

Em outro lugar no YouTube, você pode ouvir um bando de ex-presidentes, incluindo Obama, Clinton e Reagan, fazendo rap na NWA . A música e os sons de fundo ajudam a disfarçar algumas das falhas robóticas óbvias, mas mesmo nesse estado imperfeito, o potencial é óbvio.

Experimentamos as ferramentas em Assemelha-se a AI e Descrição e criou um clone de voz. O Descript usa um mecanismo de clonagem de voz que foi originalmente chamado de Lyrebird e foi particularmente impressionante. Ficamos chocados com a qualidade. Ouvir sua própria voz dizer coisas que você sabe que nunca disse é enervante.

Definitivamente, há uma qualidade robótica no discurso, mas em uma escuta casual, a maioria das pessoas não teria nenhuma razão para pensar que era uma farsa.

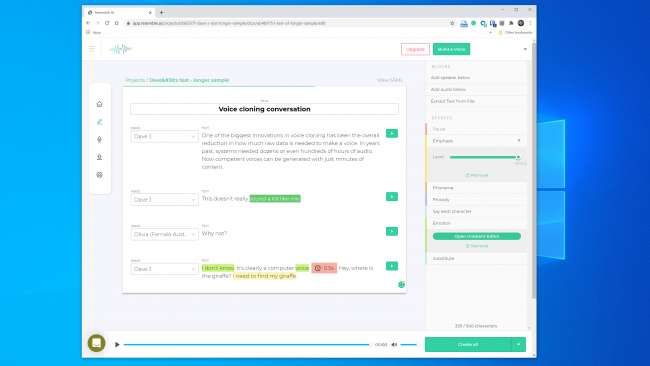

Tínhamos esperanças ainda maiores para o Resemble AI. Ele fornece as ferramentas para criar uma conversa com várias vozes e variar a expressividade, a emoção e o ritmo do diálogo. No entanto, não achamos que o modelo de voz capturasse as qualidades essenciais da voz que usamos. Na verdade, era improvável que enganasse ninguém.

Um representante da Resemble AI nos disse que "a maioria das pessoas fica maravilhada com os resultados se o fizerem corretamente" Construímos um modelo de voz duas vezes com resultados semelhantes. Então, evidentemente, nem sempre é fácil fazer um clone de voz que você pode usar para realizar um assalto digital.

Mesmo assim, o fundador do Lyrebird (que agora faz parte da Descript), Kundan Kumar, sente que já ultrapassamos esse limite.

“Para uma pequena porcentagem dos casos, ele já está lá”, disse Kumar. “Se eu usar áudio sintético para mudar algumas palavras em um discurso, já é tão bom que você terá dificuldade em saber o que mudou.”

Também podemos presumir que essa tecnologia só ficará melhor com o tempo. Os sistemas precisarão de menos áudio para criar um modelo, e processadores mais rápidos serão capazes de construir o modelo em tempo real. A inteligência artificial mais inteligente aprenderá como adicionar uma cadência humana mais convincente e ênfase na fala sem ter um exemplo para trabalhar.

O que significa que podemos estar cada vez mais perto da disponibilidade generalizada de clonagem de voz sem esforço.

A Ética da Caixa de Pandora

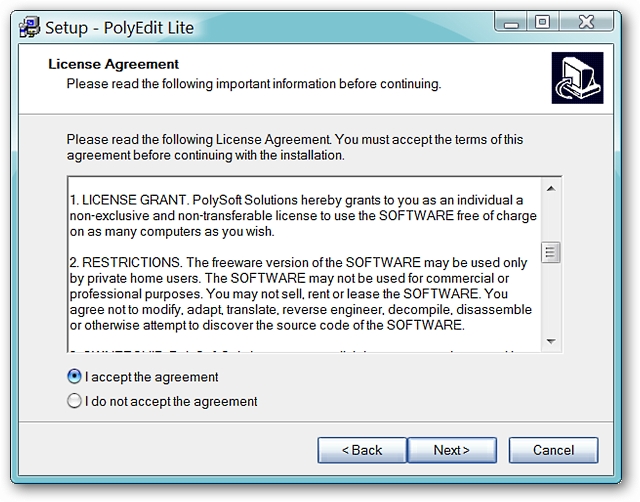

A maioria das empresas que trabalham neste espaço parece preparada para lidar com a tecnologia de forma segura e responsável. Assemelhar-se a AI, por exemplo, tem uma seção inteira de “Ética” em seu site , e o seguinte trecho é encorajador:

“Trabalhamos com empresas por meio de um processo rigoroso para garantir que a voz que estão clonando possa ser usada por elas e que tenha o consentimento adequado com os dubladores”.

Da mesma forma, Kumar disse que o Lyrebird estava preocupado com o uso indevido desde o início. É por isso que agora, como parte do Descript, ele só permite que as pessoas clonem sua própria voz. Na verdade, tanto Resemble quanto Descript exigem que as pessoas gravem suas amostras ao vivo para evitar a clonagem de voz não consensual.

É encorajador que os principais atores comerciais tenham imposto algumas diretrizes éticas. No entanto, é importante lembrar que essas empresas não são as guardiãs dessa tecnologia. Já existem várias ferramentas de código aberto disponíveis, para as quais não existem regras. De acordo com Henry Ajder, chefe de inteligência de ameaças da Deeptrace , você também não precisa de conhecimento avançado de codificação para usá-lo indevidamente.

“Muito do progresso no espaço veio por meio do trabalho colaborativo em locais como o GitHub, usando implementações de código aberto de artigos acadêmicos publicados anteriormente”, disse Ajder. “Ele pode ser usado por qualquer pessoa com proficiência moderada em codificação.”

Os profissionais de segurança já viram tudo isso antes

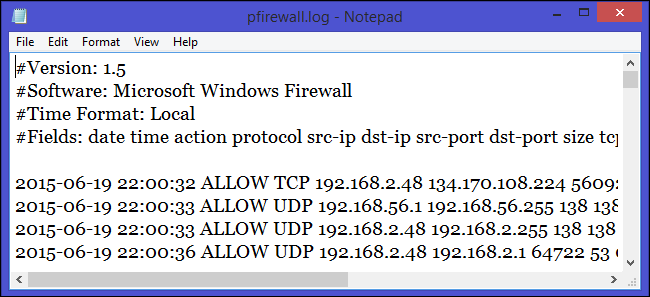

Os criminosos tentaram roubar dinheiro por telefone muito antes que a clonagem de voz fosse possível, e especialistas em segurança sempre estiveram à disposição para detectar e prevenir isso. Compania de segurança Pindrop tenta impedir a fraude bancária, verificando se o chamador é quem afirma ser do áudio. Somente em 2019, Pindrop afirma ter analisado 1,2 bilhão de interações de voz e evitado cerca de US $ 470 milhões em tentativas de fraude.

Antes da clonagem de voz, os fraudadores tentaram várias outras técnicas. O mais simples foi ligar de outro lugar com informações pessoais sobre a marca.

“Nossa assinatura acústica nos permite determinar se uma chamada está realmente vindo de um telefone Skype na Nigéria por causa das características do som”, disse o CEO da Pindrop, Vijay Balasubramaniyan. “Então, podemos comparar o fato de saber que o cliente usa um telefone AT&T em Atlanta.”

Alguns criminosos também fizeram carreira usando sons de fundo para despistar representantes bancários.

“Há um fraudador que chamamos de Homem de Galinha que sempre tinha galos em segundo plano”, disse Balasubramaniyan. “E há uma senhora que usou um bebê chorando ao fundo para essencialmente convencer os agentes do call center de que‘ ei, estou passando por um momento difícil ’para obter simpatia.”

E há os criminosos homens que perseguem contas bancárias de mulheres.

“Eles usam a tecnologia para aumentar a frequência da voz, para soar mais feminina”, explica Balasubramaniyan. Eles podem ser bem-sucedidos, mas “ocasionalmente, o software bagunça e eles soam como Alvin e os Esquilos”.

Claro, a clonagem de voz é apenas o desenvolvimento mais recente nesta guerra cada vez maior. As empresas de segurança já detectaram fraudadores usando áudio sintético em pelo menos um ataque de caça submarina.

“Com o alvo certo, o pagamento pode ser enorme”, disse Balasubramaniyan. “Portanto, faz sentido dedicar tempo para criar uma voz sintetizada do indivíduo certo.”

Alguém pode saber se uma voz é falsa?

Quando se trata de reconhecer se uma voz foi falsa, há boas e más notícias. O ruim é que os clones de voz estão melhorando a cada dia. Os sistemas de aprendizado profundo estão ficando mais inteligentes e criando vozes mais autênticas, que exigem menos áudio para serem criadas.

Como você pode ver neste clipe de Presidente Obama dizendo a MC Ren para tomar posição , também já chegamos ao ponto em que um modelo de voz cuidadosamente construído e de alta fidelidade pode soar muito convincente para o ouvido humano.

Quanto mais longo for um clipe de som, maior será a probabilidade de você notar que há algo errado. No entanto, para clipes mais curtos, você pode não notar que é sintético - especialmente se você não tiver motivos para questionar sua legitimidade.

Quanto mais clara for a qualidade do som, mais fácil será perceber os sinais de um deepfake de áudio. Se alguém estiver falando diretamente em um microfone com qualidade de estúdio, você poderá ouvir com atenção. Mas uma gravação de chamada telefônica de má qualidade ou uma conversa capturada em um dispositivo portátil em um estacionamento barulhento será muito mais difícil de avaliar.

A boa notícia é que, mesmo que os humanos tenham dificuldade em separar o real do falso, os computadores não têm as mesmas limitações. Felizmente, já existem ferramentas de verificação de voz. Pindrop tem um que opõe sistemas de aprendizado profundo uns aos outros. Ele usa ambos para descobrir se uma amostra de áudio é a pessoa que deveria ser. No entanto, também examina se um humano pode até mesmo fazer todos os sons da amostra.

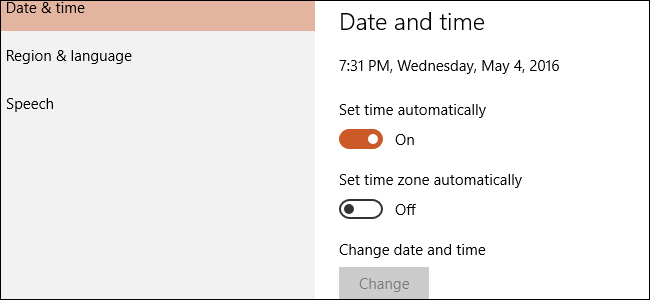

Dependendo da qualidade do áudio, cada segundo de fala contém entre 8.000-50.000 amostras de dados que podem ser analisadas.

“O que normalmente procuramos são limitações na fala devido à evolução humana”, explicou Balasubramaniyan.

Por exemplo, dois sons vocais têm uma separação mínima possível um do outro. Isso ocorre porque não é fisicamente possível pronunciá-los mais rápido devido à velocidade com que os músculos da boca e das cordas vocais podem se reconfigurar.

“Quando olhamos para áudio sintetizado”, disse Balasubramaniyan, “às vezes vemos coisas e dizemos, 'isso nunca poderia ter sido gerado por um humano porque a única pessoa que poderia ter gerado isso precisa ter um pescoço de 2,10 metros. ”

Também existe uma classe de som chamada "fricativas". Eles são formados quando o ar passa por uma estreita constrição em sua garganta quando você pronuncia letras como f, s, v e z. As fricativas são especialmente difíceis de dominar por sistemas de aprendizado profundo porque o software tem problemas para diferenciá-las do ruído.

Portanto, pelo menos por enquanto, o software de clonagem de voz tropeça pelo fato de que os humanos são sacos de carne que fluem o ar através de orifícios em seus corpos para falar.

“Eu fico brincando que deepfakes são muito lamentáveis”, disse Balasubramaniyan. Ele explicou que é muito difícil para os algoritmos distinguir as extremidades das palavras do ruído de fundo em uma gravação. Isso resulta em muitos modelos de voz com fala mais lenta do que os humanos.

“Quando um algoritmo vê isso acontecendo muito”, disse Balasubramaniyan, “estatisticamente, torna-se mais confiante de que o áudio foi gerado, e não o humano”.

A Resemble AI também está lidando com o problema de detecção de frente com o Resemblyzer, uma ferramenta de aprendizado profundo de código aberto disponível no GitHub . Ele pode detectar vozes falsas e realizar verificação de alto-falante.

É preciso vigilância

É sempre difícil adivinhar o que o futuro reserva, mas essa tecnologia quase certamente só ficará melhor. Além disso, qualquer pessoa pode ser potencialmente uma vítima - não apenas indivíduos de alto perfil, como funcionários eleitos ou CEOs de bancos.

“Acho que estamos à beira da primeira violação de áudio em que as vozes das pessoas são roubadas”, previu Balasubramaniyan.

No momento, porém, o risco no mundo real de deepfakes de áudio é baixo. Já existem ferramentas que parecem fazer um bom trabalho na detecção de vídeo sintético.

Além disso, a maioria das pessoas não corre o risco de um ataque. De acordo com Ajder, os principais atores comerciais “estão trabalhando em soluções sob medida para clientes específicos, e a maioria tem diretrizes éticas bastante boas quanto a com quem trabalhariam ou não”.

A verdadeira ameaça está à frente, no entanto, como Ajder explicou:

“A Caixa de Pandora será composta de pessoas remendando implementações de código aberto da tecnologia em aplicativos ou serviços cada vez mais fáceis de usar e acessíveis que não têm aquele tipo de camada ética de escrutínio que as soluções comerciais têm no momento.”

Isso provavelmente é inevitável, mas as empresas de segurança já estão inserindo detecção de áudio falso em seus kits de ferramentas. Ainda assim, ficar seguro requer vigilância.

“Fizemos isso em outras áreas de segurança”, disse Ajder. “Muitas organizações passam muito tempo tentando entender qual é a próxima vulnerabilidade de dia zero, por exemplo. O áudio sintético é simplesmente a próxima fronteira. ”

RELACIONADOS: O que é um Deepfake e devo me preocupar?