Video deepfakes înseamnă că nu poți avea încredere în tot ceea ce vezi. Acum, deepfakes audio ar putea însemna că nu mai poți avea încredere în urechile tale. A fost acesta într-adevăr președintele care a declarat război Canadei? Este într-adevăr tatăl tău la telefon care îi cere parola de e-mail?

Adăugați o altă îngrijorare existențială la lista modului în care ne-ar putea distruge în mod inevitabil propriul hubris. În epoca Reagan, singurele riscuri tehnologice reale erau amenințarea războiului nuclear, chimic și biologic.

În anii care au urmat, am avut ocazia să ne obsedăm de goo-ul gri al nanotehnologiei și de pandemiile globale. Acum, avem deepfakes - oameni care își pierd controlul asupra asemănării sau vocii lor.

Ce este un Deepfake audio?

Majoritatea dintre noi am văzut o video deepfake , în care algoritmii de învățare profundă sunt folosiți pentru a înlocui o persoană cu asemănarea cuiva. Cele mai bune sunt deranjant de realiste, iar acum a venit rândul audio. Un deepfake audio este atunci când o voce „clonată” care este potențial nedistinguibilă de cea a persoanei reale este utilizată pentru a produce sunet sintetic.

„Este ca Photoshop pentru voce”, a spus Zohaib Ahmed, CEO al Resemble AI , despre tehnologia de clonare vocală a companiei sale.

Cu toate acestea, slujbele proaste Photoshop sunt ușor demontate. O firmă de securitate cu care am vorbit a spus că, de obicei, oamenii ghicesc doar dacă un deepfake audio este real sau fals, cu o precizie de aproximativ 57% - nu mai bine decât o monedă.

În plus, deoarece atât de multe înregistrări vocale sunt de apeluri telefonice de calitate scăzută (sau înregistrate în locații zgomotoase), deepfakes audio pot fi făcute și mai indistincte. Cu cât este mai slabă calitatea sunetului, cu atât este mai greu să ridici acele semne revelatoare că o voce nu este reală.

Dar de ce ar avea cineva nevoie de un Photoshop pentru voci, oricum?

Cazul convingător pentru audio sintetic

De fapt, există o cerere enormă de sunet sintetic. Potrivit lui Ahmed, „rentabilitatea investiției este foarte imediată”.

Acest lucru este valabil mai ales atunci când vine vorba de jocuri. În trecut, vorbirea era componenta dintr-un joc imposibil de creat la cerere. Chiar și în titlurile interactive cu scene de calitate cinematografică redate în timp real, interacțiunile verbale cu personaje care nu joacă sunt întotdeauna esențial statice.

Acum, însă, tehnologia a ajuns din urmă. Studiourile au potențialul de a clona vocea unui actor și de a folosi motoare text-to-speech, astfel încât personajele să poată spune orice în timp real.

Există, de asemenea, utilizări mai tradiționale în publicitate și asistență tehnică și pentru clienți. Aici este importantă o voce care sună în mod autentic uman și răspunde personal și contextual fără aport uman.

Companiile de clonare vocală sunt, de asemenea, încântate de aplicațiile medicale. Desigur, înlocuirea vocii nu este nimic nou în medicină - Stephen Hawking a folosit faimos o voce sintetizată robotizată după ce a pierdut-o pe a sa în 1985. Cu toate acestea, clonarea vocală modernă promite ceva și mai bun.

În 2008, compania de voce sintetică, CereProc , i-a dat regretatului critic de film, Roger Ebert, vocea înapoi după ce cancerul a luat-o. CereProc a publicat o pagină web care le-a permis oamenilor să scrie mesaje care vor fi apoi rostite cu vocea fostului președinte George Bush.

„Ebert a văzut asta și s-a gândit:„ Ei bine, dacă ar putea copia vocea lui Bush, ar trebui să o poată copia pe a mea ”, a spus Matthew Aylett, șeful științific al CereProc. Ebert a cerut apoi companiei să creeze o voce de înlocuire, lucru pe care l-au făcut prin procesarea unei mari biblioteci de înregistrări vocale.

„A fost una dintre primele ori când cineva a făcut asta și a fost un real succes”, a spus Aylett.

În ultimii ani, o serie de companii (inclusiv CereProc) au lucrat cu Asociația SLA pe Proiect Revoice pentru a oferi voci sintetice celor care suferă de SLA.

Cum funcționează sunetul sintetic

Clonarea vocală are un moment chiar acum și o serie de companii dezvoltă instrumente. Resemble AI și Descriere au demonstrații online pe care oricine le poate încerca gratuit. Înregistrați doar frazele care apar pe ecran și, în doar câteva minute, este creat un model de voce.

Îi poți mulțumi AI - în special, algoritmi de învățare profundă —Pentru a fi capabil să asocieze vorbirea înregistrată la text pentru a înțelege fonemele componente care alcătuiesc vocea ta. Apoi folosește blocurile lingvistice rezultate pentru a aproxima cuvintele pe care nu te-a auzit vorbind.

Tehnologia de bază există de ceva vreme, dar, după cum a subliniat Aylett, a necesitat ajutor.

„Copierea vocii a fost cam ca a face patiserie”, a spus el. „A fost cam greu de făcut și ați avut diverse moduri în care a trebuit să-l modificați manual, pentru ca acesta să funcționeze.”

Dezvoltatorii au avut nevoie de cantități enorme de date vocale înregistrate pentru a obține rezultate acceptabile. Apoi, în urmă cu câțiva ani, au deschis porțile. Cercetările în domeniul viziunii computerizate s-au dovedit a fi critice. Oamenii de știință au dezvoltat rețele contradictorii generative (GAN), care ar putea, pentru prima dată, să extrapoleze și să facă predicții pe baza datelor existente.

„În loc ca un computer să vadă fotografia unui cal și să spună„ acesta este un cal ”, modelul meu ar putea transforma acum un cal într-o zebră”, a spus Aylett. „Deci, explozia din sinteza vorbirii se datorează acum muncii academice din viziunea computerizată”.

Una dintre cele mai mari inovații în clonarea vocii a fost reducerea generală a cantității de date brute necesare pentru a crea o voce. În trecut, sistemele aveau nevoie de zeci sau chiar sute de ore de sunet. Acum, însă, pot fi generate voci competente din doar câteva minute de conținut.

LEGATE DE: Problema cu AI: Mașinile învață lucruri, dar nu le pot înțelege

Teama existențială de a nu avea încredere în nimic

Această tehnologie, împreună cu energia nucleară, nanotehnologia, imprimarea 3D și CRISPR, sunt simultan palpitante și terifiante. La urma urmei, au existat deja cazuri în știri despre oameni înșelați de clone vocale. În 2019, o companie din Marea Britanie a susținut că este păcălit de un deepfake audio apel telefonic către conectarea banilor către criminali.

Nici nu trebuie să mergeți departe pentru a găsi falsuri audio surprinzător de convingătoare. Canalul canalului YouTube Sinteza vocală prezintă oameni cunoscuți care spun lucruri pe care nu le-au spus niciodată, cum ar fi George W. Bush citind „În Da Club” de 50 Cent . Este la fața locului.

În altă parte pe YouTube, puteți auzi o mulțime de foști președinți, inclusiv Obama, Clinton și Reagan, violând NWA . Muzica și sunetele de fundal ajută la disimularea unora dintre evidențele robotice evidente, dar chiar și în această stare imperfectă, potențialul este evident.

Am experimentat cu instrumentele pornite Resemble AI și Descriere și a creat o clonă vocală. Descrierea folosește un motor de clonare vocală care a fost inițial numit Lyrebird și a fost deosebit de impresionant. Am fost șocați de calitate. A-ți auzi propria voce spunând lucruri pe care știi că nu le-ai spus niciodată este deranjant.

Cu siguranță, există o calitate robotică a discursului, dar la o ascultare obișnuită, majoritatea oamenilor nu ar avea motive să creadă că a fost un fals.

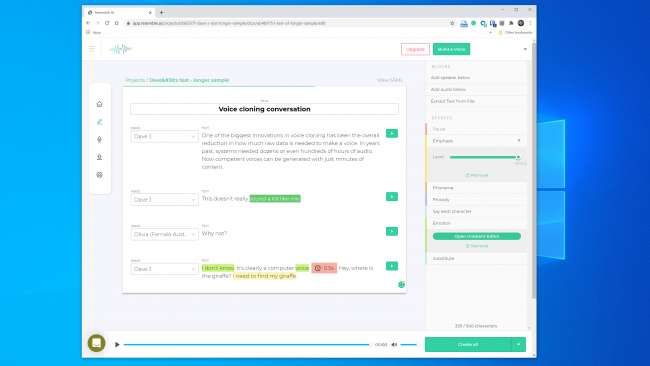

Aveam speranțe și mai mari pentru Resemble AI. Vă oferă instrumentele pentru a crea o conversație cu mai multe voci și pentru a varia expresivitatea, emoția și ritmul dialogului. Cu toate acestea, nu am crezut că modelul de voce a surprins calitățile esențiale ale vocii pe care le-am folosit. De fapt, era puțin probabil să păcălești pe cineva.

Un reprezentant Resemble AI ne-a spus „majoritatea oamenilor sunt uimiți de rezultate dacă o fac corect”. Am construit un model vocal de două ori cu rezultate similare. Deci, evident, nu este întotdeauna ușor să creezi o clonă vocală pe care o poți folosi pentru a scoate un hoist digital.

Chiar și așa, fondatorul Lyrebird (care face acum parte din Descript), Kundan Kumar, consideră că am trecut deja de acest prag.

"Pentru un mic procent din cazuri, este deja acolo", a spus Kumar. „Dacă folosesc sunetul sintetic pentru a schimba câteva cuvinte într-un discurs, este deja atât de bun încât vei avea dificultăți în a ști ce s-a schimbat.”

Putem, de asemenea, să presupunem că această tehnologie se va îmbunătăți doar cu timpul. Sistemele vor avea nevoie de mai puțin sunet pentru a crea un model, iar procesoarele mai rapide vor putea construi modelul în timp real. Inteligența artificială inteligentă va învăța cum să adauge o cadență umană mai convingătoare și să pună accent pe vorbire, fără a avea un exemplu din care să lucreze.

Ceea ce înseamnă că ne-am putea apropia de disponibilitatea pe scară largă a clonării vocale fără efort.

Etica cutiei Pandorei

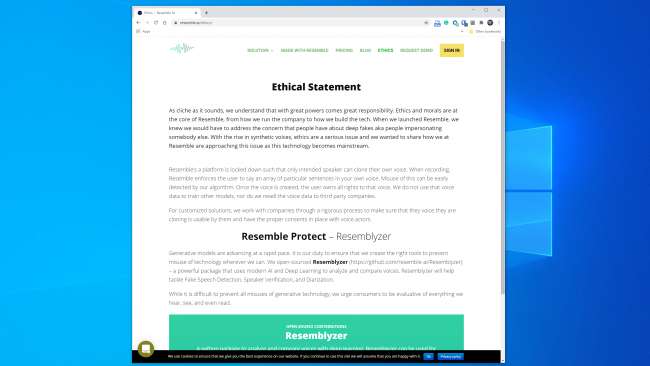

Majoritatea companiilor care lucrează în acest spațiu par pregătite să gestioneze tehnologia într-un mod sigur și responsabil. Seamănă cu AI, de exemplu, are o întreagă secțiune „Etică” de pe site-ul său web , iar următorul fragment este încurajator:

„Lucrăm cu companiile printr-un proces riguros pentru a ne asigura că vocea pe care o clonează este utilizabilă de către acestea și că avem consimțământurile corespunzătoare cu actorii de voce”

La fel, Kumar a spus că Lyrebird a fost îngrijorat de abuzul de la început. De aceea, acum, ca parte a descrierii, permite doar oamenilor să își cloneze propria voce. De fapt, atât Asemănare, cât și Descriere necesită ca oamenii să-și înregistreze mostrele în direct pentru a preveni clonarea vocală neconsensuală.

Este încurajator faptul că principalii actori comerciali au impus câteva orientări etice. Cu toate acestea, este important să ne amintim că aceste companii nu sunt purtători ai acestei tehnologii. Există o serie de instrumente open-source deja în natură, pentru care nu există reguli. Potrivit lui Henry Ajder, șeful serviciilor de informații privind amenințările din Deeptrace , de asemenea, nu aveți nevoie de cunoștințe avansate de codificare pentru a le utiliza în mod greșit.

"O mare parte din progresele realizate în spațiu au venit prin munca de colaborare în locuri precum GitHub, folosind implementări open-source ale lucrărilor academice publicate anterior", a spus Ajder. „Poate fi folosit de oricine care are o competență moderată în codificare.”

Profesioniștii în materie de securitate au văzut toate acestea înainte

Infractorii au încercat să fure bani prin telefon cu mult înainte ca clonarea vocală să fie posibilă, iar experții în securitate au fost întotdeauna în seamă pentru a o detecta și preveni. Companie de securitate Pindrop încearcă să oprească frauda bancară verificând dacă un apelant este cine afirmă că este din sunet. Numai în 2019, Pindrop susține că a analizat 1,2 miliarde de interacțiuni vocale și a prevenit aproximativ 470 de milioane de dolari în încercări de fraudă.

Înainte de clonarea vocală, fraudatorii au încercat o serie de alte tehnici. Cel mai simplu a fost doar apelarea din altă parte cu informații personale despre marcă.

„Semnătura noastră acustică ne permite să stabilim că un apel vine de la un telefon Skype din Nigeria din cauza caracteristicilor sunetului”, a declarat CEO-ul Pindrop, Vijay Balasubramaniyan. „Apoi, putem compara faptul că știind că clientul folosește un telefon AT&T în Atlanta”.

Unii criminali și-au făcut cariere și din utilizarea sunetelor de fundal pentru a elimina reprezentanții bancari.

„Există un înșelător pe care l-am numit Chicken Man, care avea întotdeauna cocoși în fundal”, a spus Balasubramaniyan. „Și există o doamnă care a folosit un bebeluș plângând în fundal pentru a convinge în mod esențial agenții centrului de apel, că„ hei, trec printr-un moment dificil ”pentru a obține simpatie.”

Și apoi sunt criminali de sex masculin care urmăresc conturile bancare ale femeilor.

„Folosesc tehnologia pentru a crește frecvența vocii lor, pentru a suna mai feminin”, a explicat Balasubramaniyan. Acestea pot avea succes, dar „ocazional, software-ul se încurcă și sună ca Alvin și Chipmunks”.

Desigur, clonarea vocală este doar cea mai recentă dezvoltare din acest război în continuă escaladare. Firmele de securitate au surprins deja fraudei care utilizează sunet sintetic în cel puțin un atac de pescuit subacvatic.

"Cu ținta potrivită, plata poate fi masivă", a spus Balasubramaniyan. „Deci, are sens să dedici timpul pentru a crea o voce sintetizată a persoanei potrivite.”

Poate cineva să spună dacă o voce este falsă?

Când este vorba să recunoaștem dacă o voce a fost falsificată, există atât vești bune, cât și rele. Rău este că clonele vocale se îmbunătățesc în fiecare zi. Sistemele de învățare profundă devin mai inteligente și fac voci mai autentice, care necesită mai puțin sunet pentru a crea.

După cum vă puteți da seama din acest clip de Președintele Obama îi spune lui MC Ren să ia poziție De asemenea, am ajuns deja la punctul în care un model de voce de înaltă fidelitate și atent construit poate suna destul de convingător pentru urechea umană.

Cu cât un clip audio este mai lung, cu atât este mai probabil să observați că este ceva în neregulă. Cu toate acestea, pentru clipuri mai scurte, este posibil să nu observați că este sintetic - mai ales dacă nu aveți motive să puneți la îndoială legitimitatea acestuia.

Cu cât este mai clară calitatea sunetului, cu atât este mai ușor să observați semne ale unui deepfake audio. Dacă cineva vorbește direct într-un microfon de calitate studio, veți putea asculta cu atenție. Dar o înregistrare a unui apel telefonic de calitate slabă sau o conversație capturată pe un dispozitiv portabil într-un garaj de parcare zgomotos va fi mult mai greu de evaluat.

Vestea bună este că, chiar dacă oamenii au probleme cu separarea realului de fals, computerele nu au aceleași limitări. Din fericire, există deja instrumente de verificare vocală. Pindrop are unul care pune sistemele de învățare profundă unul împotriva celuilalt. Acesta le folosește pe ambele pentru a descoperi dacă un eșantion audio este persoana care ar trebui să fie. Cu toate acestea, examinează și dacă un om poate chiar să scoată toate sunetele din eșantion.

În funcție de calitatea sunetului, fiecare secundă de vorbire conține între 8.000-50.000 de eșantioane de date care pot fi analizate.

„Lucrurile pe care le căutăm în mod obișnuit sunt constrângeri ale vorbirii datorate evoluției umane”, a explicat Balasubramaniyan.

De exemplu, două sunete vocale au o separare minimă posibilă între ele. Acest lucru se datorează faptului că nu este posibil din punct de vedere fizic să le spui mai repede datorită vitezei cu care mușchii din gură și corzile vocale se pot reconfigura.

„Când ne uităm la sunetul sintetizat”, a spus Balasubramaniyan, „uneori vedem lucruri și spunem:„ acest lucru nu ar fi putut fi generat niciodată de un om, deoarece singura persoană care ar fi putut genera acest lucru trebuie să aibă un gât lung de șapte picioare. ”

Există, de asemenea, o clasă de sunet numită „fricative”. Se formează atunci când aerul trece printr-o constricție îngustă în gât când pronunți litere precum f, s, v și z. Fricativele sunt greu de stăpânit pentru sistemele de învățare profundă, deoarece software-ul întâmpină probleme în a le diferenția de zgomot.

Deci, cel puțin pentru moment, software-ul de clonare vocală este împiedicat de faptul că oamenii sunt saci de carne care curg aer prin găurile din corpul lor pentru a vorbi.

"Continu să glumesc că deepfakes sunt foarte whiney", a spus Balasubramaniyan. El a explicat că este foarte greu pentru algoritmi să distingă capetele cuvintelor de zgomotul de fundal dintr-o înregistrare. Acest lucru are ca rezultat numeroase modele de voce cu vorbire care se îndepărtează mai mult decât o fac oamenii.

„Când un algoritm vede că acest lucru se întâmplă foarte mult”, a spus Balasubramaniyan, „statistic, devine mai încrezător că sunetul a fost generat spre deosebire de cel uman”.

Resemble AI abordează de asemenea problema de detectare direct cu Resemblyzer, un instrument open-source de învățare profundă disponibil pe GitHub . Poate detecta voci false și poate efectua verificarea difuzoarelor.

Este nevoie de vigilență

Este întotdeauna dificil să ghiciți ce ar putea depăși viitorul, dar această tehnologie aproape că se va îmbunătăți. De asemenea, oricine ar putea fi o victimă - nu doar persoane cu profil înalt, cum ar fi funcționarii aleși sau directorii executivi bancari.

„Cred că suntem la un pas de prima încălcare a sunetului în care vocile oamenilor sunt furate”, a prezis Balasubramaniyan.

În prezent, totuși, riscul real din cauza deepfakes audio este redus. Există deja instrumente care par să facă o treabă destul de bună de detectare a videoclipurilor sintetice.

În plus, majoritatea oamenilor nu prezintă riscul unui atac. Potrivit lui Ajder, principalii jucători comerciali „lucrează la soluții personalizate pentru anumiți clienți și majoritatea au orientări etice destul de bune cu privire la cine ar lucra și nu ar lucra”.

Adevărata amenințare se află în față, totuși, după cum Ajder a explicat mai departe:

„Pandora’s Box vor fi oameni care vor pune laolaltă implementările open-source ale tehnologiei în aplicații sau servicii din ce în ce mai ușor de utilizat, accesibile, care nu au acel tip de strat etic de control pe care îl fac soluțiile comerciale în acest moment”.

Acest lucru este probabil inevitabil, dar companiile de securitate introduc deja detectarea audio falsă în seturile lor de instrumente. Totuși, păstrarea în siguranță necesită vigilență.

„Am făcut acest lucru în alte zone de securitate”, a spus Ajder. „Multe organizații petrec mult timp încercând să înțeleagă care este următoarea vulnerabilitate de zero zile, de exemplu. Sunetul sintetic este pur și simplu următoarea frontieră. ”

LEGATE DE: Ce este un Deepfake și ar trebui să fiu îngrijorat?