Als u lang genoeg naar een lijst met monitorresoluties staart, ziet u misschien een patroon: veel van de verticale resoluties, vooral die van gaming- of multimediadisplays, zijn veelvouden van 360 (720, 1080, 1440, enz.) Maar waarom is dit precies de geval? Is het willekeurig of is er iets meer aan het werk?

De vraag- en antwoordsessie van vandaag komt tot ons dankzij SuperUser - een onderdeel van Stack Exchange, een community-gedreven groepering van Q & A-websites.

De vraag

SuperUser-lezer Trojandestroy merkte onlangs iets op over zijn display-interface en heeft antwoorden nodig:

YouTube heeft onlangs 1440p-functionaliteit toegevoegd en voor het eerst realiseerde ik me dat alle (de meeste?) Verticale resoluties veelvouden zijn van 360.

Is dit alleen omdat de kleinste gangbare resolutie 480 × 360 is en het handig is om veelvouden te gebruiken? (Ik twijfel er niet aan dat veelvouden handig zijn.) En / of was dat de eerste resolutie die kon worden bekeken / handig formaat, zodat hardware (tv's, monitoren, enz.) Groeide met 360 in gedachten?

Als je het verder wilt, waarom zou je dan geen vierkante resolutie hebben? Of iets anders ongewoons? (Ervan uitgaande dat het gebruikelijk genoeg is dat het zichtbaar is). Is het slechts een situatie die het oog behaagt?

Dus waarom is de weergave een veelvoud van 360?

Het antwoord

SuperUser-bijdrager User26129 biedt ons niet alleen een antwoord waarom het numerieke patroon bestaat, maar ook een geschiedenis van schermontwerp in het proces:

Oké, er zijn een paar vragen en veel factoren hier. Resoluties zijn een heel interessant gebied van marketing voor psychooptics-meetings.

Allereerst, waarom zijn de verticale resoluties op youtube veelvouden van 360. Dit is natuurlijk gewoon willekeurig, er is geen echte reden waarom dit het geval is. De reden is dat de resolutie hier niet de beperkende factor is voor YouTube-video's - bandbreedte wel. YouTube moet elke video die een paar keer wordt geüpload opnieuw coderen en probeert zo min mogelijk hercoderingsformaten / bitrates / resoluties te gebruiken om alle verschillende gebruiksscenario's te dekken. Voor mobiele apparaten met een lage resolutie hebben ze 360 × 240, voor mobiele apparaten met een hogere resolutie is er 480p, en voor het computerpubliek is er 360p voor 2xISDN / vaste lijnen voor meerdere gebruikers, 720p voor DSL en 1080p voor sneller internet. Er waren een tijdje andere codecs dan h.264, maar deze worden langzaamaan uitgefaseerd, waarbij h.264 in wezen de formaatoorlog heeft 'gewonnen' en alle computers hiervoor zijn uitgerust met hardwarecodecs.

Nu zijn er ook enkele interessante psycho-psycho-analytics aan de gang. Zoals ik al zei: resolutie is niet alles. 720p met echt sterke compressie kan en zal er slechter uitzien dan 240p bij een zeer hoge bitsnelheid. Maar aan de andere kant van het spectrum: meer bits met een bepaalde resolutie gooien, maakt het op een bepaald punt niet op magische wijze beter. Hier is een optimum, dat natuurlijk afhangt van zowel resolutie als codec. In het algemeen: de optimale bitsnelheid is eigenlijk evenredig met de resolutie.

De volgende vraag is dus: wat voor soort oplossingsstappen zijn zinvol? Blijkbaar hebben mensen ongeveer een 2x hogere resolutie nodig om echt een duidelijk verschil te zien (en te prefereren). Alles minder dan dat en veel mensen zullen gewoon geen moeite doen met de hogere bitsnelheden, ze gebruiken hun bandbreedte liever voor andere dingen. Dit is al heel lang geleden onderzocht en is de belangrijkste reden waarom we van 720 × 576 (415kpix) naar 1280 × 720 (922kpix) gingen, en dan weer van 1280 × 720 naar 1920 × 1080 (2MP). Daartussenin is geen haalbaar optimalisatiedoel. En nogmaals, 1440P is ongeveer 3,7 MP, nog eens ~ 2x meer dan HD. Je zult daar een verschil zien. 4K is daarna de volgende stap.

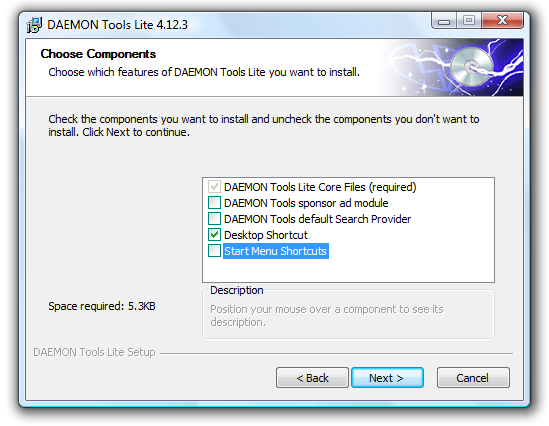

Het volgende is dat magische aantal van 360 verticale pixels. Eigenlijk is het magische getal 120 of 128. Alle resoluties zijn tegenwoordig een soort veelvoud van 120 pixels, vroeger waren ze veelvouden van 128. Dit is iets dat net uit de LCD-paneelindustrie is voortgekomen. LCD-panelen gebruiken zogenaamde lijndrivers, kleine chips die aan de zijkanten van uw LCD-scherm zitten en die bepalen hoe helder elke subpixel is. Omdat historisch gezien, om redenen die ik niet echt zeker weet, waarschijnlijk geheugenbeperkingen, deze veelvoudige van 128 of veelvoud van 120 resoluties al bestonden, werden de industriestandaard lijnstuurprogramma's stuurprogramma's met 360 lijnuitgangen (1 per subpixel) . Als je je 1920 × 1080-scherm zou afbreken, zou ik er geld op steken met 16 lijndrivers aan de boven- / onderkant en 9 aan een van de zijkanten. Oh hey, dat is 16: 9. Raad eens hoe voor de hand liggend die resolutie-keuze was toen 16: 9 werd ‘uitgevonden’.

Dan is er de kwestie van de beeldverhouding. Dit is echt een heel ander vakgebied van de psychologie, maar het komt erop neer: historisch gezien hebben mensen geloofd en gemeten dat we een soort breedbeeldweergave van de wereld hebben. Natuurlijk geloofden mensen dat de meest natuurlijke weergave van gegevens op een scherm in een breedbeeldweergave zou zijn, en dit is waar de grote anamorfische revolutie van de jaren '60 vandaan kwam toen films werden opgenomen in steeds grotere beeldverhoudingen.

Sindsdien is dit soort kennis verfijnd en grotendeels ontkracht. Ja, we hebben een groothoekweergave, maar het gebied waar we echt scherp kunnen zien - het midden van ons zicht - is redelijk rond. Enigszins elliptisch en platgedrukt, maar niet echt meer dan ongeveer 4: 3 of 3: 2. Dus voor gedetailleerde weergave, bijvoorbeeld voor het lezen van tekst op een scherm, kunt u het grootste deel van uw detailzicht gebruiken door een bijna vierkant scherm te gebruiken, een beetje zoals de schermen tot halverwege de jaren 2000.

Maar nogmaals, dit is niet hoe marketing het opnam. Computers werden vroeger vooral gebruikt voor productiviteit en gedetailleerd werk, maar naarmate ze commoditiseerden en naarmate de computer evolueerde als apparaat voor mediaconsumptie, gebruikten mensen hun computer meestal niet altijd voor hun werk. Ze gebruikten het om media-inhoud te bekijken: films, televisieseries en foto's. En voor dat soort kijken krijgt u de meeste ‘immersiefactor’ als het scherm zo veel mogelijk van uw zicht (inclusief uw perifere visie) vult. Dat betekent breedbeeld.

Maar er is nog meer marketing. Toen detailwerk nog een belangrijke factor was, gaven mensen om resolutie. Zoveel mogelijk pixels op het scherm. SGI verkocht bijna 4K CRT's! De meest optimale manier om het maximale aantal pixels uit een glazen substraat te halen, is door het zo vierkant mogelijk te snijden. 1: 1- of 4: 3-schermen hebben de meeste pixels per diagonale inch. Maar met schermen die steeds meer verbruiken, werd inch-formaat belangrijker, niet het aantal pixels. En dit is een heel ander optimalisatiedoel. Om de meeste diagonale inches uit een substraat te halen, wil je het scherm zo breed mogelijk maken. Eerst kregen we 16:10, daarna 16: 9 en er zijn redelijk succesvolle paneelfabrikanten geweest die 22: 9- en 2: 1-schermen maakten (zoals Philips). Hoewel de pixeldichtheid en de absolute resolutie een paar jaar daalden, gingen de inch-maten omhoog en dat is wat verkocht. Waarom zou u een 19 ″ 1280 × 1024 kopen als u een 21 ″ 1366 × 768 kunt kopen? Eh ...

Ik denk dat dat hier ongeveer alle belangrijke aspecten omvat. Er is natuurlijk meer; bandbreedtelimieten van HDMI, DVI, DP en natuurlijk VGA speelden een rol, en als je teruggaat naar de jaren vóór 2000, speelden het grafische geheugen, de bandbreedte in de computer en simpelweg de beperkingen van commercieel verkrijgbare RAMDAC's een belangrijke rol. Maar voor de overwegingen van vandaag is dit ongeveer alles wat u moet weten.

Iets toe te voegen aan de uitleg? Geluid uit in de reacties. Wilt u meer antwoorden lezen van andere technisch onderlegde Stack Exchange-gebruikers? Bekijk hier de volledige discussiethread .