モニターの解像度のリストを十分に長く見つめると、パターンに気付くかもしれません。垂直解像度の多く、特にゲームやマルチメディアディスプレイの解像度は、360の倍数(720、1080、1440など)です。場合?それは恣意的ですか、それとももっと何かが働いていますか?

今日の質疑応答セッションは、コミュニティ主導のQ&AWebサイトのグループであるStackExchangeの下位区分であるSuperUserの好意で行われます。

質問

スーパーユーザーリーダーのTrojandestroyは最近、彼のディスプレイインターフェイスについて何かに気づき、回答が必要です。

YouTubeは最近1440pの機能を追加しましたが、すべての(ほとんど?)垂直解像度が360の倍数であることに初めて気づきました。

これは、最小の一般的な解像度が480×360であり、倍数を使用すると便利だからですか? (倍数が便利であることは間違いありません。)および/または最初の表示可能/便利なサイズの解像度だったので、ハードウェア(TV、モニターなど)は360を念頭に置いて成長しましたか?

さらに進んで、正方形の解像度を持ってみませんか?それとも何か変わったものですか? (表示できるほど通常の状態であると想定)。それは単に目を楽しませてくれる状況ですか?

では、なぜディスプレイが360の倍数になるのでしょうか。

答え

スーパーユーザーの寄稿者であるUser26129は、数値パターンが存在する理由についての回答だけでなく、その過程での画面設計の履歴も提供します。

さて、ここにはいくつかの質問と多くの要因があります。決議は、マーケティングに出会う心理光学の非常に興味深い分野です。

まず第一に、なぜYouTubeの垂直解像度が360の倍数であるのか。これはもちろん任意であり、これが当てはまる本当の理由はありません。その理由は、ここでの解像度がYouTubeビデオの制限要因ではなく、帯域幅が制限要因であるためです。 Youtubeは、数回アップロードされたすべてのビデオを再エンコードする必要があり、さまざまなユースケースをすべてカバーするために、再エンコード形式/ビットレート/解像度をできるだけ少なくしようとします。低解像度のモバイルデバイスの場合は360×240、高解像度のモバイルの場合は480p、コンピューター群衆の場合は2xISDN /マルチユーザー固定電話用に360p、DSL用に720p、高速インターネット用に1080pです。しばらくの間、h.264以外のコーデックがいくつかありましたが、これらは徐々に段階的に廃止され、h.264は本質的にフォーマット戦争に「勝ち」、すべてのコンピューターにこのためのハードウェアコーデックが装備されています。

現在、いくつかの興味深いサイコオプティクスも進行中です。私が言ったように、解決はすべてではありません。非常に強力な圧縮を備えた720pは、非常に高いビットレートで240pよりも悪く見える可能性があります。しかし、スペクトルの反対側では、特定の解像度でより多くのビットをスローしても、あるポイントを超えて魔法のように良くなるわけではありません。ここには最適なものがありますが、これはもちろん解像度とコーデックの両方に依存します。一般的に、最適なビットレートは実際には解像度に比例します。

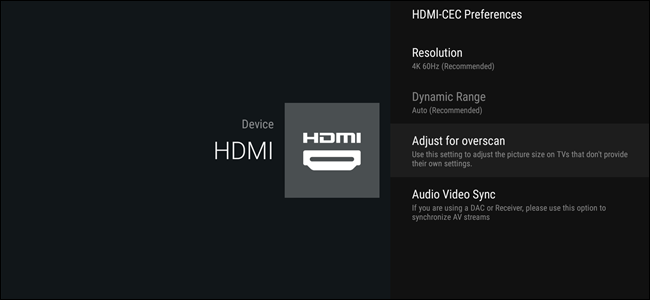

したがって、次の質問は、どのような解決手順が意味をなすのかということです。どうやら、人々は実際に顕著な違いを見る(そして好む)ために解像度を約2倍上げる必要があります。それより少ないものは何でも、多くの人々は単に高いビットレートを気にせず、むしろ他のもののために彼らの帯域幅を使用したいと思います。これはかなり昔に研究されており、720×576(415kpix)から1280×720(922kpix)に、そして再び1280×720から1920×1080(2MP)に移行した大きな理由です。その間のものは、実行可能な最適化ターゲットではありません。また、1440Pは約3.7MPであり、HDの約2倍になります。そこに違いがあります。 4Kはその後の次のステップです。

次は、360垂直ピクセルの魔法の数です。実際、マジックナンバーは120または128です。すべての解像度は、現在では120ピクセルの倍数であり、以前は128の倍数でした。これはLCDパネル業界から生まれたばかりです。 LCDパネルは、ラインドライバーと呼ばれるものを使用します。これは、LCD画面の側面に配置され、各サブピクセルの明るさを制御する小さなチップです。歴史的に、おそらくメモリの制約など、はっきりとはわからない理由で、これらの128の倍数または120の倍数の解像度はすでに存在していたため、業界標準のラインドライバーは360ライン出力(サブピクセルあたり1つ)のドライバーになりました。 。 1920×1080の画面を壊すとしたら、上下に16個、片側に9個のラインドライバーがあることにお金をかけます。ああ、それは16:9です。 16:9が「発明」されたときに、解像度の選択がどれほど明白に戻ったかを推測します。

次に、アスペクト比の問題があります。これは実際にはまったく異なる心理学の分野ですが、要約すると、歴史的に、人々は私たちが一種のワイドスクリーンの世界観を持っていると信じて測定してきました。当然のことながら、人々は、画面上のデータの最も自然な表現はワイドスクリーンビューであると信じていました。これは、フィルムがこれまで以上に広いアスペクト比で撮影されたときに60年代の大きなアナモルフィック革命が起こった場所です。

それ以来、この種の知識は洗練され、ほとんどが暴かれてきました。はい、広角の視野はありますが、実際にはっきりと見える領域、つまり視界の中心はかなり丸いです。わずかに楕円形で押しつぶされていますが、実際には約4:3または3:2を超えていません。そのため、たとえば画面上のテキストを読むなどの詳細な表示では、2000年代半ばまでの画面に少し似た、ほぼ正方形の画面を使用することで、詳細なビジョンのほとんどを利用できます。

ただし、これもマーケティングが採用した方法ではありません。昔のコンピューターは主に生産性と詳細な作業に使用されていましたが、コモディティ化され、メディア消費デバイスとしてのコンピューターが進化するにつれて、人々は必ずしもコンピューターを仕事に使用することはほとんどありませんでした。彼らはそれを使って、映画、テレビシリーズ、写真などのメディアコンテンツを視聴しました。そして、そのような表示では、画面ができるだけ多くの視力(周辺視野を含む)を満たしている場合に、最も「没入率」が得られます。これはワイドスクリーンを意味します。

しかし、まだまだマーケティングがあります。詳細な作業が依然として重要な要素であったとき、人々は解決を気にしました。画面上のできるだけ多くのピクセル。 SGIはほぼ4KのCRTを販売していました!ガラス基板から最大量のピクセルを取り出すための最適な方法は、可能な限り正方形にカットすることです。 1:1または4:3の画面では、対角インチあたりのピクセル数が最も多くなります。しかし、ディスプレイの消費が増えるにつれ、ピクセル数ではなく、インチサイズがより重要になりました。そして、これは完全に異なる最適化ターゲットです。素材から最も斜めのインチを引き出すには、画面をできるだけ広くする必要があります。最初に16:10、次に16:9を取得し、22:9および2:1の画面(Philipsなど)を作成するパネルメーカーは中程度に成功しています。ピクセル密度と絶対解像度が数年間低下したにもかかわらず、インチサイズが上昇し、それが売れたものです。 21インチの1366×768を購入できるのに、なぜ19インチの1280×1024を購入するのですか?え…

ここでは、すべての主要な側面をカバーしていると思います。もちろん、もっとあります。 HDMI、DVI、DP、そしてもちろんVGAの帯域幅制限が役割を果たしました。2000年代以前に戻ると、グラフィックメモリ、コンピュータ内帯域幅、そして単に市販のRAMDACの制限が重要な役割を果たしました。しかし、今日の考慮事項として、これはあなたが知る必要があるすべてについてです。

説明に追加するものがありますか?コメントで音を立ててください。他の技術に精通したStackExchangeユーザーからの回答をもっと読みたいですか? ここで完全なディスカッションスレッドをチェックしてください 。