Apple lægger deres ry for at sikre, at de data, de indsamler fra dig, forbliver private. Hvordan? Ved at bruge noget, der hedder "Differential Privacy."

Hvad er differentieret privatliv?

Æble forklarer det som sådan:

Apple bruger Differential Privacy-teknologi til at opdage brugsmønstrene for et stort antal brugere uden at gå på kompromis med individuelt privatliv. For at skjule en persons identitet tilføjer Differential Privacy matematisk støj til en lille prøve af individets brugsmønster. Da flere mennesker deler det samme mønster, begynder generelle mønstre at dukke op, som kan informere og forbedre brugeroplevelsen.

Filosofien bag Differential Privacy er denne: enhver bruger, hvis enhed, hvad enten det er en iPhone, iPad eller Mac, tilføjer en beregning til en større pulje af samlede data (et stort billede dannet af forskellige mindre billeder), bør ikke afsløres som kilden, endsige hvilke data de bidrog med.

Apple er heller ikke det eneste firma, der gør dette - både Google og Microsoft brugte det endnu tidligere. Men Apple populariserede det ved at tale om det i detaljer på det 2016 WWDC keynote .

Så hvordan adskiller dette sig fra andre anonymiserede data, spørger du? Nå, anonymiserede data kan stadig bruges til at udlede personlige oplysninger, hvis du ved nok om en person.

Lad os sige, at en hacker kan få adgang til en anonymiseret database, der afslører en virksomheds lønningsliste. Lad os sige, at de også ved, at medarbejder X flytter til et andet område. Hacker kunne derefter simpelthen spørge databasen før og efter medarbejder X flytter og let udlede sin indkomst.

For at beskytte medarbejder X's følsomme oplysninger ændrer Differential Privacy dataene med matematiske "støj" og andre teknikker, så hvis du spørger til databasen, vil du kun modtage en tilnærmelse af hvor meget (eller nogen anden) medarbejder X blev betalt.

Derfor bevares hans privatliv på grund af "forskellen" mellem de leverede data og den støj, der er tilføjet dem, så det er så vagt nok, at det praktisk taget er umuligt at vide, om de data, du ser på, faktisk er en bestemt persons.

Hvordan fungerer Apples differentielle privatliv?

Differentiel privatliv er et relativt nyt koncept , men ideen er, at den kan give en virksomhed stor indsigt baseret på data fra sine brugere uden at vide hvad Nemlig disse data siger, eller fra hvem de stammer.

Apple er for eksempel afhængig af tre komponenter for at få sit arbejde med Differential Privacy til at fungere på din Mac eller iOS-enhed: hashing, subsampling og støjinjektion.

Hashing tager en tekststreng og forvandler den til en kortere værdi med en fast længde og blander disse taster op i irreversibelt tilfældige strenge med unikke tegn eller "hash". Dette tilslører dine data, så enheden ikke gemmer noget af det i sin oprindelige form.

Delsampling betyder, at Apple i stedet for at samle hvert ord, en person skriver, kun bruger en mindre prøve af dem. Lad os f.eks. Sige, at du har en lang tekstsamtale med en ven, der bruger emoji. I stedet for at samle hele denne samtale bruger undersampling muligvis kun de dele, Apple er interesseret i, såsom emoji.

Endelig injicerer din enhed støj og tilføjer tilfældige data i det originale datasæt for at gøre det mere vagt. Det betyder, at Apple får et resultat, der er blevet maskeret nogensinde så lidt og derfor ikke er helt nøjagtigt.

Alt dette sker på din enhed, så det er allerede blevet forkortet, blandet, samplet og sløret, før det overhovedet sendes til skyen, så Apple kan analysere.

Hvor bruges Apples differentielle fortrolighed?

Der er en række tilfælde, hvor Apple magt ønsker at indsamle data for at forbedre sine apps og tjenester. Lige nu bruger Apple kun Differential Privacy på fire specifikke områder.

- Når nok mennesker erstatter et ord med en bestemt emoji, bliver det et forslag for alle.

- Når nye ord føjes til nok lokale ordbøger til at blive betragtet som almindelige, tilføjer Apple det også til alle andres ordbog.

- Du kan bruge et søgeudtryk i Spotlight, og det giver derefter appforslag og åbner det link i den nævnte app eller giver dig mulighed for at installere det fra App Store. Sig f.eks. At du søger efter "Star Trek", hvilket foreslår IMDB-appen. Jo flere mennesker åbner eller installerer IMDB-appen, jo mere vises den i alles søgeresultater.

- Det giver mere nøjagtige resultater for opslagstip i noter. Sig for eksempel, at du har en note med ordet "æble" i. Du foretager en opslagssøgning, og det giver dig ikke kun resultater til ordboksdefinitionen, men også Apples websted, placeringer af Apple Stores osv. Formodentlig jo flere mennesker trykker på bestemte resultater, jo højere og oftere vises de i Lookup for alle andre.

Lad os bruge emojis som et eksempel. I iOS 10, Apple introducerede en ny emoji-erstatningsfunktion på iMessage. Skriv ordet "kærlighed", og du kan erstatte det med en hjerteemoji. skriv ordet "hund", og - du gættede det - du kan erstatte det med en hundemoji.

På samme måde er det muligt for din iPhone at forudsige, hvilken emoji du vil have, så hvis du skriver en besked "Jeg vil gå med hunden", vil din iPhone med fordel foreslå hundens emoji.

Så Apple tager alle de små stykker iMessage-data, det indsamler, undersøger dem som en helhed og kan udlede mønstre fra, hvad folk skriver, og i hvilken sammenhæng. Dette betyder, at din iPhone kan give dig smartere valg, fordi den drager fordel af alle de tekstsamtaler, som andre opretter, og tænker, "dette er sandsynligvis den emoji, du vil have."

Det tager en landsby (af Emoji)

Ulempen ved Differential Privacy er, at det ikke giver nøjagtige resultater i små prøver. Det ligger i at gøre specifikke data vage, så de kan ikke tilskrives en bruger. For at det skal fungere og fungere godt, skal mange brugere deltage.

Det er som at se på et bitmappet billede meget tæt på. Du vil ikke kunne se, hvad det er, hvis du kun ser på nogle få bits, men når du træder tilbage og ser på det hele, bliver billedet klarere og mere defineret, selvom det ikke er superhøjt løsning.

For at forbedre emoji-udskiftning og forudsigelse (blandt andet) skal Apple således indsamle iPhone- og Mac-data fra hele verden for at give det et stadig klarere billede af, hvad folk laver og dermed forbedre sine apps og tjenester. Det henvender sig til al denne randomiserede, støjende, Crowdsourced-data og udvinder dem til mønstre - såsom hvor mange brugere der bruger ferskenemoji i stedet for "butt".

Så kraften i Differential Privacy er afhængig af, at Apple er i stand til at undersøge store mængder aggregerede data, samtidig med at det sikres, at det ikke er noget klogere om, hvem der sender dem disse data.

Sådan fravælger du differentieret privatliv i iOS og macOS

Hvis du stadig ikke er overbevist om, at Differential Privacy er det rigtige for dig, har du held og lykke. Du kan fravælge direkte fra enhedens indstillinger.

På din iOS-enhed skal du trykke let på "Indstillinger" og derefter på "Privatliv".

På privatlivsskærmen skal du trykke på "Diagnostik og brug".

Til sidst skal du trykke på "Send ikke" på skærmbilledet Diagnostik og brug.

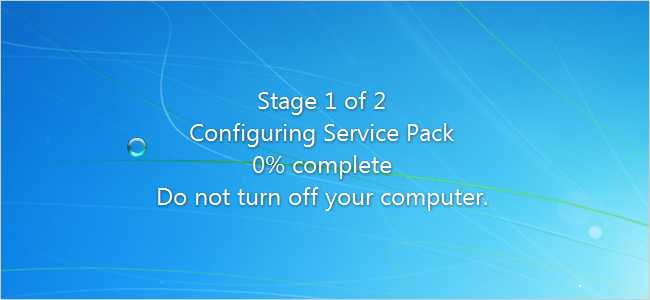

På macOS skal du åbne systemindstillingerne og klikke på "Sikkerhed og fortrolighed".

I indstillingerne Sikkerhed og fortrolighed skal du klikke på fanen "Privatliv" og derefter sikre dig, at "Send diagnosticerings- og brugsdata til Apple" ikke er markeret. Bemærk, at du bliver nødt til at klikke på låsikonet i nederste venstre hjørne og indtaste din systemadgangskode, før du kan foretage denne ændring.

Naturligvis, der er meget mere ved Differential Privacy , både i teorien og anvendelsen, end denne forenklede forklaring. Kødet og kartoflerne afhænger stærkt af nogle seriøse matematikker, og som sådan kan det blive ret tungt og kompliceret.

Forhåbentlig giver dette dig dog en idé om, hvordan det fungerer, og at du føler dig mere sikker på, at virksomheder indsamler bestemte data uden frygt for at blive identificeret.