Apple sätter sitt rykte för att säkerställa att de uppgifter som samlas in från dig förblir privata. På vilket sätt? Genom att använda något som kallas "Differentiell integritet."

Vad är differentiell integritet?

Äpple förklarar det som sådant:

Apple använder Differential Privacy-teknik för att upptäcka användningsmönstren för ett stort antal användare utan att äventyra individuell integritet. För att dölja en individs identitet lägger Differential Privacy till matematiskt brus i ett litet urval av individens användningsmönster. Eftersom fler människor delar samma mönster börjar allmänna mönster dyka upp, vilket kan informera och förbättra användarupplevelsen.

Filosofin bakom Differentiell integritet är den här: varje användare vars enhet, oavsett om det är en iPhone, iPad eller Mac, lägger till en beräkning i en större pool av samlade data (en stor bild bildad av varierande mindre bilder), bör inte avslöjas som källan, än mindre vilken data de bidrog med.

Apple är inte det enda företaget som gör det heller - både Google och Microsoft använde det ännu tidigare. Men Apple populariserade det genom att prata om det i detalj vid sitt 2016 WWDC keynote .

Så hur skiljer sig detta från andra anonymiserade data, frågar du? Tja, anonymiserad data kan fortfarande användas för att härleda personlig information om du vet tillräckligt om en person.

Låt oss säga att en hackare kan komma åt en anonymiserad databas som avslöjar företagets löner. Låt oss säga att de också vet att anställd X flyttar till ett annat område. Hackaren kunde då helt enkelt fråga efter databasen före och efter att anställd X flyttar och enkelt kan dra av sin inkomst.

För att skydda anställd X: s känsliga information ändrar Differential Privacy data med matematiskt "brus" och andra tekniker så att om du frågar efter databasen får du bara en approximation av hur mycket (eller någon annan) anställd X fick betalt.

Därför bevaras hans integritet på grund av "skillnaden" mellan de levererade uppgifterna och det brus som läggs till den, så det är då vagt nog att det är praktiskt taget omöjligt att veta om den information du tittar på faktiskt är en viss individs.

Hur fungerar Apples differentiella integritet?

Differentiell integritet är ett relativt nytt koncept , men tanken är att det kan ge ett företag god insikt baserat på data från sina användare, utan att veta vad exakt den informationen säger eller från vem den kommer.

Apple, till exempel, förlitar sig på tre komponenter för att göra sitt arbete med Differentiell integritet på din Mac eller iOS-enhet: hashing, undersampling och bullerinjektion.

Hashing tar en textsträng och förvandlar den till ett kortare värde med en fast längd och blandar dessa tangenter i oåterkalleligt slumpmässiga strängar med unika tecken eller "hash". Detta döljer dina data så att enheten inte lagrar någon av dem i sin ursprungliga form.

Delprov innebär att istället för att samla in varje ord en person skriver kommer Apple bara att använda ett mindre urval av dem. Låt oss till exempel säga att du har en lång textkonversation med en vän som använder emoji. Istället för att samla hela konversationen kan delprover istället bara använda de delar Apple är intresserade av, till exempel emoji.

Slutligen injicerar din enhet brus och lägger till slumpmässiga data i den ursprungliga datasetet för att göra det mer vagt. Detta innebär att Apple får ett resultat som har maskerats någonsin så lite och därför inte är helt exakt.

Allt detta händer på din enhet, så det har redan förkortats, blandats, samplats och suddats ut innan det ens skickas till molnet för att Apple ska kunna analysera.

Var används Apples differentiella integritet?

Det finns en mängd olika fall där Apple makt vill samla in data för att förbättra sina appar och tjänster. Just nu använder Apple bara Differential Privacy på fyra specifika områden.

- När tillräckligt många människor ersätter ett ord med en viss emoji blir det ett förslag för alla.

- När nya ord läggs till i tillräckligt många lokala ordböcker för att betraktas som vanligt kommer Apple också att lägga till det i alla andras ordlista.

- Du kan använda en sökterm i Spotlight, och den kommer då att ge appförslag och öppna den länken i nämnda app eller låta dig installera den från App Store. Säg till exempel att du söker efter "Star Trek", vilket föreslår IMDB-appen. Ju fler människor öppnar eller installerar IMDB-appen, desto mer kommer den att visas i allas sökresultat.

- Det ger mer exakta resultat för uppslagstips i anteckningar. Anta till exempel att du har en anteckning med ordet "äpple" i den. Du gör en sökning och det ger dig resultat inte bara för ordboksdefinitionen, utan också Apples webbplats, platser för Apple Stores och så vidare. Förmodligen, ju fler människor trycker på vissa resultat, desto högre och oftare kommer de att visas i Lookup för alla andra.

Låt oss använda emojis som ett exempel. I iOS 10, Apple introducerade en ny emoji-ersättningsfunktion på iMessage. Skriv ordet "kärlek" och du kan ersätta det med en hjärtemoji. skriv ordet "hund" och - du gissade det - du kan ersätta det med en hundemoji.

På samma sätt är det möjligt för din iPhone att förutsäga vilken emoji du vill ha så att om du skriver ett meddelande "Jag ska gå med hunden" kommer din iPhone till hjälp att föreslå hundens emoji.

Så Apple tar alla de små bitarna av iMessage-data som de samlar in, undersöker dem som en helhet och kan härleda mönster från vad folk skriver och i vilket sammanhang. Det betyder att din iPhone kan ge dig smartare val eftersom den drar nytta av alla de textkonversationer som andra skapar och tänker, "det här är förmodligen den emoji du vill ha."

Det tar en by (av Emoji)

Nackdelen med Differentiell integritet är att den inte ger korrekta resultat i små prover. Dess kraft ligger i att göra specifika data vaga så att de inte kan tillskrivas någon användare. För att det ska fungera och fungera bra måste många användare delta.

Det är som att titta på ett bitmappat foto på nära håll. Du kommer inte att kunna se vad det är om du bara tittar på några bitar, men när du går tillbaka och tittar på det hela blir bilden tydligare och mer definierad, även om den inte är superhög upplösning.

För att förbättra emoji-ersättning och förutsägelse (bland annat) måste Apple samla in iPhone- och Mac-data från hela världen för att ge det en allt tydligare bild av vad människor gör och därmed förbättra sina appar och tjänster. Det vänder sig till all denna randomiserade, bullriga, massfulla data och bryter den för mönster - till exempel hur många användare som använder persikaemoji istället för "rumpa".

Så, kraften i Differential Privacy är beroende av att Apple kan undersöka stora mängder aggregerad data, samtidigt som det säkerställer att det inte är någon klokare om vem som skickar dem dessa data.

Så här väljer du bort differentiell integritet i iOS och macOS

Om du fortfarande inte är övertygad om att Differential Privacy är rätt för dig, har du tur. Du kan välja bort direkt från enhetens inställningar.

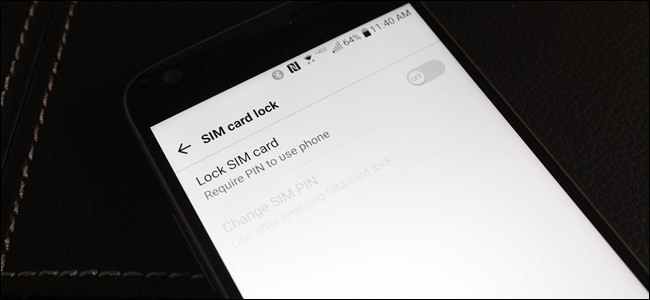

På din iOS-enhet, tryck på öppna "Inställningar" och sedan "Sekretess".

Tryck på "Diagnostik och användning" på sekretessskärmen.

Slutligen, på skärmen Diagnostik och användning, tryck på ”Skicka inte”.

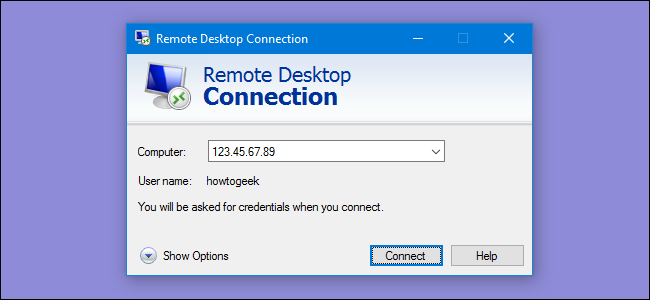

På macOS öppnar du Systeminställningar och klickar på "Säkerhet och sekretess".

I inställningarna för säkerhet och sekretess klickar du på fliken "Sekretess" och ser sedan till att "Skicka diagnostik- och användningsdata till Apple" är avmarkerat. Observera att du måste klicka på låsikonen i det nedre vänstra hörnet och ange systemlösenordet innan du kan göra denna ändring.

Självklart, Det finns mycket mer i Differential Privacy , både i teorin och tillämpningen, än denna förenklade förklaring. Köttet och potatisen av det är starkt beroende av någon seriös matematik och som sådan kan det bli ganska tungt och komplicerat.

Förhoppningsvis ger detta dig dock en uppfattning om hur det fungerar och att du känner dig mer säker på att företag samlar in viss data utan rädsla för att identifieras.

![Pokémon Go har full åtkomst till ditt Google-konto. Så här fixar du det [Updated]](https://cdn.thefastcode.com/static/thumbs/pok-mon-go-has-full-access-to-your-google-account-here-s-how-to-fix-it-updated.jpg)