Con tutto l'ottimo hardware che abbiamo a disposizione in questi giorni, sembra che dovremmo godere di una visione di ottima qualità, non importa cosa, ma se non fosse così? Il post di domande e risposte di SuperUser di oggi cerca di chiarire le cose per un lettore confuso.

La sessione di domande e risposte di oggi ci arriva per gentile concessione di SuperUser, una suddivisione di Stack Exchange, un raggruppamento guidato dalla comunità di siti web di domande e risposte.

Foto per gentile concessione di lge (Flickr) .

La domanda

Il lettore SuperUser alkamid vuole sapere perché c'è una notevole differenza di qualità tra HDMI-DVI e VGA:

Ho un monitor Dell U2312HM collegato a un laptop Dell Latitude E7440. Quando li collego tramite laptop -> cavo HDMI -> adattatore HDMI-DVI -> monitor (il monitor non ha una presa HDMI), l'immagine è molto più nitida rispetto a se collego tramite laptop -> adattatore miniDisplayPort-VGA -> VGA cavo -> monitor.

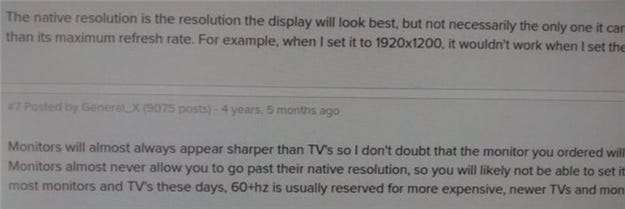

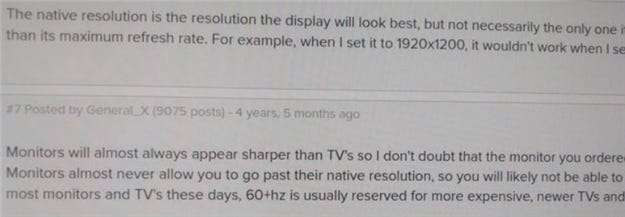

La differenza è difficile da catturare con una fotocamera, ma vedi il mio tentativo di seguito. Ho provato a giocare con le impostazioni di luminosità, contrasto e nitidezza, ma non riesco a ottenere la stessa qualità dell'immagine. La risoluzione è 1920 * 1080 con Ubuntu 14.04 come sistema operativo.

VGA:

HDMI:

Perché la qualità è diversa? È intrinseco a questi standard? Posso avere un cavo VGA difettoso o un adattatore mDP-VGA?

Perché c'è una differenza di qualità tra i due?

La risposta

I collaboratori di SuperUser Mate Juhasz, youngwt e Jarrod Christman hanno la risposta per noi. Il primo, Mate Juhasz:

VGA è l'unico segnale analogico tra quelli sopra menzionati, quindi è già una spiegazione per la differenza. L'uso dell'adattatore può peggiorare ulteriormente la qualità.

Qualche ulteriore lettura: HDMI vs DisplayPort vs DVI vs VGA

Seguito dalla risposta di youngwt:

Supponendo che luminosità, contrasto e nitidezza siano gli stessi in entrambi i casi, potrebbero esserci altri due motivi per cui il testo è più nitido con HDMI-DVI.

Il primo è già stato affermato, VGA è analogico, quindi dovrà passare attraverso una conversione da analogico a digitale all'interno del monitor. Questo in teoria ridurrà la qualità dell'immagine.

In secondo luogo, supponendo che tu stia utilizzando Windows, esiste una tecnica chiamata ClearType (sviluppata da Microsoft) che migliora l'aspetto del testo manipolando i pixel secondari di un monitor LCD. VGA è stato sviluppato pensando ai monitor CRT e la nozione di pixel secondario non è la stessa. A causa del requisito per ClearType di utilizzare uno schermo LCD e del fatto che lo standard VGA non comunica all'host le specifiche dello schermo, ClearType sarebbe disabilitato con una connessione VGA.

Ricordo di aver sentito parlare di ClearType da uno dei suoi creatori su un podcast per This (). Developers (). Life () IIRC, ma questo Wikipedia article supporta anche la mia teoria. Inoltre HDMI è retrocompatibile con DVI e DVI supporta l'identificazione elettronica del display (EDID).

Con la nostra risposta finale di Jarrod Christman:

Gli altri fanno alcuni punti positivi, ma il motivo principale è un evidente disallineamento di fase e orologio. VGA è analogico e soggetto a interferenze e mancata corrispondenza dei lati di invio e ricezione analogici. Normalmente si userebbe uno schema come questo:

Quindi regola l'orologio e la fase del monitor per ottenere la migliore corrispondenza e l'immagine più nitida. Tuttavia, poiché è analogico, queste regolazioni possono cambiare nel tempo, quindi idealmente dovresti usare solo un segnale digitale.

Hai qualcosa da aggiungere alla spiegazione? Audio disattivato nei commenti. Vuoi leggere altre risposte da altri utenti esperti di tecnologia Stack Exchange? Dai un'occhiata al thread di discussione completo qui .