Έχουμε την τάση να εμπιστευόμαστε το περιεχόμενο βίντεο και ηχογραφήσεων Αλλά με το AI, το πρόσωπο ή η φωνή όλων μπορούν να αναδημιουργηθούν με ακρίβεια. Το προϊόν είναι deepfake, πλαστοπροσωπία που μπορεί να χρησιμοποιηθεί για μιμίδια, παραπληροφόρηση ή πορνό.

Μια ματιά στο Νίκολας Κέιτζ βαθιά ή Jordan Peele's deepfake PSA καθιστά σαφές ότι έχουμε να κάνουμε με μια παράξενη νέα τεχνολογία. Αυτά τα παραδείγματα, αν και σχετικά ακίνδυνα, δημιουργούν ερωτήματα σχετικά με το μέλλον. Μπορούμε να εμπιστευτούμε βίντεο και ήχο; Μπορούμε να κατηγορούμε τους ανθρώπους για τις ενέργειές τους στην οθόνη; Είμαστε έτοιμοι για deepfakes;

Οι Deepfakes είναι καινούργιες, εύκολες και γρήγορες

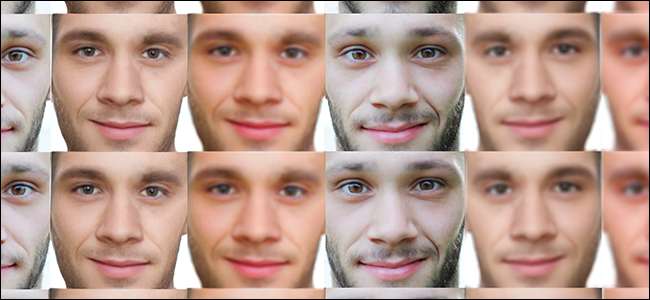

Η τεχνολογία Deepfake είναι μόνο λίγα χρόνια, αλλά έχει ήδη εκραγεί σε κάτι που είναι τόσο συναρπαστικό όσο και ανησυχητικό. Ο όρος "deepfake", που επινοήθηκε σε ένα νήμα Reddit το 2017, χρησιμοποιείται για να περιγράψει την αναδημιουργία της εμφάνισης ή της φωνής ενός ανθρώπου μέσω της τεχνητής νοημοσύνης. Παραδόξως, σχεδόν οποιοσδήποτε μπορεί να δημιουργήσει ένα deepfake με έναν κακό υπολογιστή, κάποιο λογισμικό και μερικές ώρες εργασίας.

Όπως και με οποιαδήποτε νέα τεχνολογία, υπάρχει κάποια σύγχυση γύρω από deepfakes. Το βίντεο «μεθυσμένος Pelosi» είναι ένα εξαιρετικό παράδειγμα αυτής της σύγχυσης. Οι Deepfakes κατασκευάζονται από την AI και είναι κατασκευασμένες για να πλαστογραφούν άτομα. Το βίντεο "dunk Pelosi", το οποίο έχει αναφερθεί ως deepfake, είναι στην πραγματικότητα ένα βίντεο της Nancy Pelosi που έχει επιβραδύνθηκε και διορθώθηκε το βήμα για να προσθέσετε ένα εφέ κρυφής ομιλίας.

Αυτό είναι που κάνει το deepfakery διαφορετικό από, για παράδειγμα, το CGI Carrie Fisher στο Star Wars: Rogue One. Ενώ η Disney ξόδεψε πολλά χρήματα για να μελετήσει το πρόσωπο της Carrie Fisher και να την αναδημιουργήσει με το χέρι, ένας σπασίκλας με κάποιο λογισμικό deepfake μπορεί κάντε την ίδια δουλειά δωρεάν σε μια μέρα. Το AI κάνει την εργασία απίστευτα απλή, φθηνή και πειστική

Πώς να φτιάξετε ένα Deepfake

Όπως ένας μαθητής σε μια τάξη, το AI πρέπει να «μάθει» πώς να εκτελεί την επιδιωκόμενη εργασία του. Αυτό το κάνει μέσω μιας διαδικασίας δοκιμής και σφάλματος brute-force, συνήθως αναφέρεται ως μηχανική μάθηση ή βαθιά μάθηση . Μια τεχνητή νοημοσύνη που έχει σχεδιαστεί για να ολοκληρώσει το πρώτο επίπεδο των Super Mario Bros, για παράδειγμα, θα παίζει το παιχνίδι ξανά και ξανά μέχρι να καταλάβει τον καλύτερο τρόπο για να κερδίσει. Το άτομο που σχεδιάζει το AI πρέπει να παρέχει ορισμένα δεδομένα για να ξεκινήσει η κατάσταση, μαζί με μερικούς «κανόνες» όταν τα πράγματα πάνε στραβά. Εκτός από αυτό, το AI κάνει όλη τη δουλειά.

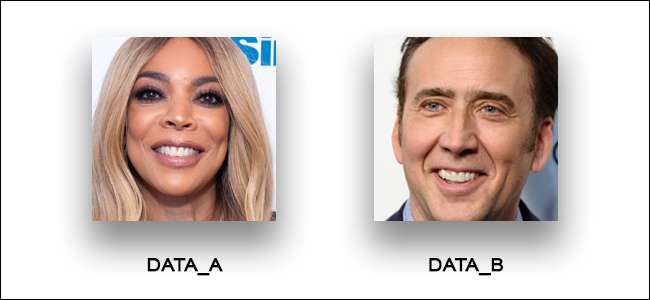

Το ίδιο ισχύει και για την αναψυχή προσώπου deepfake. Αλλά, φυσικά, η αναδημιουργία προσώπων δεν είναι η ίδια με το να χτυπάς ένα βιντεοπαιχνίδι. Αν επρόκειτο να δημιουργήσουμε ένα deepfake του Nicholas Cage που θα φιλοξενήσει το σόου Wendy Williams, εδώ θα χρειαζόμασταν:

- Ένα βίντεο προορισμού : Από τώρα, τα deepfakes λειτουργούν καλύτερα με καθαρά, καθαρά βίντεο προορισμού. Γι 'αυτό και μερικά από τα πιο πειστικά βαθιά είναι πολιτικοί. τείνουν να στέκονται ακίνητοι σε βάθρο κάτω από σταθερό φωτισμό Χρειαζόμαστε λοιπόν ένα βίντεο του Wendy να κάθεται και να μιλάει.

- Δύο σύνολα δεδομένων : Για να φαίνονται ακριβείς οι κινήσεις του στόματος και του κεφαλιού, χρειαζόμαστε ένα σύνολο δεδομένων του προσώπου του Wendy Williams και ένα σύνολο δεδομένων του προσώπου του Nicholas Cage. Εάν η Wendy κοιτάζει προς τα δεξιά, χρειαζόμαστε μια φωτογραφία του Nicholas Cage που κοιτάζει προς τα δεξιά. Εάν η Wendy ανοίξει το στόμα της, χρειαζόμαστε μια εικόνα του Cage που ανοίγει το στόμα του.

Μετά από αυτό, αφήνουμε το AI να κάνει τη δουλειά του. Προσπαθεί να δημιουργήσει το deepfake ξανά και ξανά, μαθαίνοντας από τα λάθη του στην πορεία. Απλό, σωστά; Λοιπόν, ένα βίντεο με το πρόσωπο του Κέιτζ στο σώμα του Γουέντι Γουίλιαμ δεν πρόκειται να ξεγελάσει κανέναν, οπότε πώς μπορούμε να προχωρήσουμε λίγο πιο μακριά;

Τα πιο πειστικά (και δυνητικά επιβλαβή) ψεύτικα ψεύτικα είναι όλα τα πλαστοπροσωπία. Το δημοφιλές Ομπάμα του Ομπάμα από τον Jordan Peele είναι ένα καλό παράδειγμα. Ας κάνουμε λοιπόν μία από αυτές τις πλαστοπροσωπίες. Ας δημιουργήσουμε ένα βαθύ ψεύτικο του Mark Zuckerberg, δηλώνοντας το μίσος του στα μυρμήγκια - αυτό ακούγεται πειστικό, σωστά; Να τι χρειαζόμαστε:

- Ένα βίντεο προορισμού : Αυτό θα μπορούσε να είναι ένα βίντεο του ίδιου του Zuckerberg ή ενός ηθοποιού που μοιάζει με τον Zuckerberg. Εάν το βίντεο προορισμού μας είναι ηθοποιός, απλώς θα επικολλήσουμε το πρόσωπο του Zuckerberg στον ηθοποιό.

- Δεδομένα φωτογραφίας : Χρειαζόμαστε φωτογραφίες του Zuckerberg να μιλάνε, να αναβοσβήνουν και να μετακινούνται. Αν υπερθέτουμε το πρόσωπό του σε έναν ηθοποιό, θα χρειαστούμε επίσης ένα σύνολο δεδομένων για τις κινήσεις του προσώπου του ηθοποιού.

- Η φωνή του Zuck : Το deepfake πρέπει να ακούγεται σαν The Zuck. Μπορούμε να το κάνουμε καταγράφοντας έναν πλαστογράφο ή αναδημιουργώντας τη φωνή του Zuckerberg με AI. Για να αναδημιουργήσουμε τη φωνή του, τρέχουμε απλά ηχητικά δείγματα του Zuckerberg μέσω ενός AI Αποδημητικό πτηνό της αυστραλίας και, στη συνέχεια, πληκτρολογήστε τι θέλουμε να πει.

- Ένα Lip-Sync AI : Εφόσον είμαστε προσθέτωντας τη φωνή του ψεύτικου Zuckerberg στο βίντεό μας, μια AI-συγχρονισμού χειλιών πρέπει να διασφαλίσει ότι οι βαθιές κινήσεις του προσώπου ταιριάζουν με αυτά που λέγονται.

Δεν προσπαθούμε να υποβαθμίσουμε τη δουλειά και την τεχνογνωσία που πηγαίνει στο deepfakery. Αλλά σε σύγκριση με τη δουλειά εκατομμυρίων δολαρίων CGI που έφερε Η Audrey Hepburn επέστρεψε από τους νεκρούς , deepfakes είναι μια βόλτα στο πάρκο. Και παρόλο που δεν έχουμε υποβληθεί ακόμη σε μια πολιτική ή διασημότητα, ακόμα και τα πιο τρελά, πιο προφανή deepfakes έχουν προκαλέσει πραγματική ζημιά.

ΣΧΕΤΙΖΟΜΑΙ ΜΕ: Το πρόβλημα με την τεχνητή νοημοσύνη: Οι μηχανές μαθαίνουν πράγματα, αλλά δεν μπορούν να τα καταλάβουν

Οι Deepfakes έχουν ήδη προκαλέσει βλάβη στον πραγματικό κόσμο

Από τώρα, η πλειοψηφία των deepfakes είναι μόνο memes του Nicholas Cage, ανακοινώσεις δημόσιας υπηρεσίας και ανατριχιαστικό πορνό διασημοτήτων. Αυτά τα σημεία πώλησης είναι σχετικά αβλαβή και εύκολα αναγνωρίσιμα, αλλά σε ορισμένες περιπτώσεις, τα deepfakes χρησιμοποιούνται επιτυχώς για να διαδώσουν παραπληροφόρηση και να βλάψουν τη ζωή άλλων.

Στην Ινδία, οι deepfakes χρησιμοποιούνται από ινδουιστές εθνικιστές για να δυσφημίσουν και να υποκινήσουν βία κατά γυναικών δημοσιογράφων. Το 2018, δημοσιογράφος ονόματι Η Ράνα Ayyub έπεσε θύμα σε μια τέτοια εκστρατεία παραπληροφόρησης, η οποία περιελάμβανε ένα deepfake βίντεο του προσώπου της που τοποθετήθηκε σε ένα πορνογραφικό βίντεο. Αυτό οδήγησε σε άλλες μορφές διαδικτυακής παρενόχλησης και της απειλή σωματικής βίας .

Συχνά, η τεχνολογία deepfake χρησιμοποιείται συχνά για τη δημιουργία πορνό χωρίς εκδίκηση. Οπως και ανέφερε ο Αντιπρόεδρος , πολλοί χρήστες στο φόρουμ Reddit που έχουν τώρα απαγορευτεί, ρωτήθηκαν πώς να δημιουργήσουν deepfakes πρώην φίλων, φίλων και συμμαθητών (ναι, παιδική πορνογραφία). Το πρόβλημα είναι τόσο μεγάλο που η Βιρτζίνια αποκλείει πλέον κάθε μορφή συναινετικής πορνογραφίας, συμπεριλαμβανομένων των deepfakes .

Καθώς τα deepfakes γίνονται όλο και πιο πειστικά, η τεχνολογία αναμφίβολα θα χρησιμοποιηθεί για πιο αμφίβολους σκοπούς. Υπάρχει όμως η πιθανότητα να αντιδράσουμε υπερβολικά, σωστά; Δεν είναι αυτό το πιο φυσικό βήμα μετά το Photoshop;

Οι Deepfakes είναι μια φυσική επέκταση των διδακτορικών εικόνων

Ακόμα και στο πιο βασικό τους επίπεδο, οι deepfakes είναι ανησυχητικές. Εμπιστευόμαστε τις ηχογραφήσεις βίντεο και ήχου για να καταγράφουμε τα λόγια και τις ενέργειες των ανθρώπων χωρίς προκατάληψη ή παραπληροφόρηση. Κατά κάποιον τρόπο, η απειλή των deepfakes δεν είναι καθόλου νέα. Υπήρχε από τότε που αρχίσαμε να χρησιμοποιούμε τη φωτογραφία.

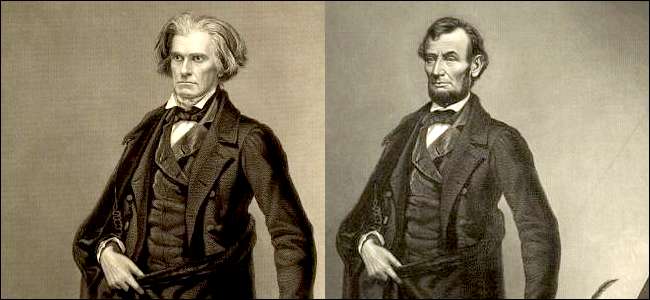

Πάρτε, για παράδειγμα, τις λίγες φωτογραφίες που υπάρχουν από τον Abraham Lincoln. Η πλειοψηφία αυτών των φωτογραφιών (συμπεριλαμβανομένων των πορτρέτων της πένας και του λογαριασμού των πέντε δολαρίων) ήταν γιατροί από έναν φωτογράφο που ονομάζεται Mathew Brady για να βελτιώσει την αίσθηση εμφάνισης του Λίνκολν (ειδικά τον λεπτό λαιμό του) Μερικά από αυτά τα πορτρέτα επεξεργάστηκαν με τρόπο που θυμίζει deepfakes, με το κεφάλι του Λίνκολν να επικαλύπτεται στα σώματα «ισχυρών» ανδρών όπως το Calhoun (το παρακάτω παράδειγμα είναι μια χάραξη, όχι μια φωτογραφία).

Αυτό ακούγεται σαν ένα παράξενο κομμάτι της δημοσιότητας, αλλά κατά τη διάρκεια της δεκαετίας του 1860, η φωτογραφία έφερε ένα ορισμένο ποσό «αλήθειας» που τώρα κρατούμε για ηχογραφήσεις βίντεο και ήχου. Θεωρήθηκε ότι ήταν το πολικό αντίθετο της τέχνης— μια επιστήμη . Αυτές οι φωτογραφίες είχαν συνταχθεί για να δυσφημίσουν σκόπιμα τις εφημερίδες που επέκριναν τον Λίνκολν για το αδύναμο σώμα του. Στο τέλος, λειτούργησε. Οι Αμερικανοί εντυπωσιάστηκαν από τη φιγούρα του Λίνκολν και ο ίδιος ο Λίνκολν ισχυρίστηκε ότι οι φωτογραφίες του Μπράντυ “ με έκανε πρόεδρο .”

Η σύνδεση μεταξύ deepfakes και επεξεργασίας φωτογραφιών του 19ου αιώνα είναι περίεργα παρηγορητική. Μας προσφέρει την αφήγηση ότι, παρόλο που αυτή η τεχνολογία έχει σοβαρές συνέπειες, δεν είναι κάτι που είναι τελείως εκτός ελέγχου μας. Δυστυχώς, όμως, αυτή η αφήγηση μπορεί να μην ισχύει για πολύ καιρό.

Δεν θα είμαστε σε θέση να εντοπίζουμε το Deepfakes για πάντα

Έχουμε συνηθίσει να εντοπίζουμε ψεύτικες εικόνες και βίντεο με τα μάτια μας. Είναι εύκολο να το δεις Οικογενειακό πορτρέτο του Joseph Goebbels και πείτε , "Υπάρχει κάτι περίεργο για αυτόν τον άντρα στην πλάτη." Μια ματιά στο Φωτογραφίες προπαγάνδας της Βόρειας Κορέας καθιστά προφανές ότι, χωρίς μαθήματα YouTube, οι άνθρωποι πιπιλίζουν το Photoshop. Και τόσο εντυπωσιακό όσο και τα deepfakes, είναι ακόμα δυνατό για να εντοπίσετε μόνο ένα βαθύ ψεύτικο.

Αλλά δεν θα είμαστε σε θέση να εντοπίσουμε deepfakes για πολύ περισσότερο. Κάθε χρόνο, τα deepfakes γίνονται πιο πειστικά και ακόμη πιο εύκολα στη δημιουργία. Μπορείτε να κάνετε ένα deepfake με μία μόνο φωτογραφία και μπορείτε να χρησιμοποιήσετε το AI όπως Αποδημητικό πτηνό της αυστραλίας να κλωνοποιήσουμε τις φωνές σε λιγότερο από ένα λεπτό. Deepfakes υψηλής τεχνολογίας που συγχωνεύουν ψεύτικο βίντεο και ήχο είναι απίστευτα πειστικά, ακόμη και όταν έχουν δημιουργηθεί για να μιμούνται αναγνωρίσιμες μορφές όπως Mark Zuckerberg .

Στο μέλλον, ενδέχεται να χρησιμοποιήσουμε AI, αλγόριθμους και τεχνολογία blockchain για την καταπολέμηση των deepfakes. Θεωρητικά, το AI θα μπορούσε να σαρώσει βίντεο για να ψάξει για deepfake " δακτυλικά αποτυπώματα , "Και η τεχνολογία blockchain που είναι εγκατεστημένη σε λειτουργικά συστήματα θα μπορούσε να επισημάνει χρήστες ή αρχεία που έχουν αγγίξει λογισμικό deepfake.

Εάν αυτές οι μέθοδοι κατά των ψαριών σας φαίνονται ανόητες, τότε εγγραφείτε στο κλαμπ. Ακόμη και ερευνητές της τεχνητής νοημοσύνης είναι αμφίβολο ότι υπάρχει μια πραγματική λύση στα deepfakes. Καθώς το λογισμικό ανίχνευσης βελτιώνεται, έτσι και τα deepfakes. Τελικά, θα φτάσουμε σε ένα σημείο όπου τα deepfakes θα είναι αδύνατο να εντοπιστούν και θα έχουμε πολύ περισσότερα να ανησυχούμε από τα ψεύτικα διασημότερα πορνό και βίντεο του Nicolas Cage.