We hebben de neiging om de inhoud van video- en audio-opnamen te vertrouwen. Maar met AI kan iemands gezicht of stem met uiterste nauwkeurigheid worden nagemaakt. Het product is een deepfake, een nabootsing die kan worden gebruikt voor memes, verkeerde informatie of porno.

Een blik op de Nicholas Cage deepfakes of Jordan Peele's deepfake PSA maakt duidelijk dat we te maken hebben met vreemde nieuwe technologie. Deze voorbeelden zijn relatief onschadelijk, maar roepen vragen op over de toekomst. Kunnen we video en audio vertrouwen? Kunnen we mensen verantwoordelijk houden voor hun acties op het scherm? Zijn we klaar voor deepfakes?

Deepfakes zijn nieuw, gemakkelijk te maken en groeien snel

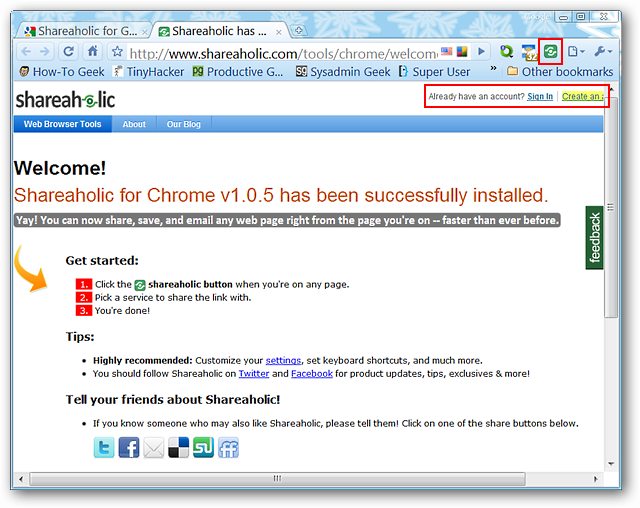

Deepfake-technologie is nog maar een paar jaar oud, maar is al geëxplodeerd tot iets dat zowel boeiend als verontrustend is. De term 'deepfake', die in 2017 op een Reddit-thread werd bedacht, wordt gebruikt om het nabootsen van het uiterlijk of de stem van een mens door middel van kunstmatige intelligentie te beschrijven. Verrassend genoeg kan bijna iedereen een deepfake maken met een waardeloze pc, wat software en een paar uur werk.

Zoals bij elke nieuwe technologie, is er enige verwarring rond deepfakes. De video "dronken Pelosi" is een uitstekend voorbeeld van deze verwarring. Deepfakes worden gemaakt door AI en zijn gemaakt om zich voor te doen als mensen. De 'dunk Pelosi'-video, waarnaar wordt verwezen als een deepfake, is eigenlijk gewoon een video van Nancy Pelosi die is vertraagd en gecorrigeerd om een onduidelijk spraakeffect toe te voegen.

Dit is ook wat deepfakery anders maakt dan bijvoorbeeld de CGI Carrie Fisher in Star Wars: Rogue One. Terwijl Disney veel geld besteedde aan het bestuderen van Carrie Fisher's gezicht en het met de hand herscheppen, kan een nerd met wat deepfake-software doe hetzelfde werk gratis in één dag. AI maakt het werk ongelooflijk eenvoudig, goedkoop en overtuigend.

Hoe maak je een deepfake

Net als een leerling in een klaslokaal, moet AI 'leren' hoe de beoogde taak moet worden uitgevoerd. Het doet dit door middel van een proces van brute-force vallen en opstaan, meestal aangeduid als machine learning of deep learning . Een AI die is ontworpen om het eerste niveau van Super Mario Bros te voltooien, zal het spel bijvoorbeeld keer op keer spelen totdat het weet wat de beste manier is om te winnen. De persoon die de AI ontwerpt, moet wat gegevens verstrekken om dingen op gang te krijgen, samen met een paar "regels" als er onderweg iets misgaat. Afgezien daarvan doet de AI al het werk.

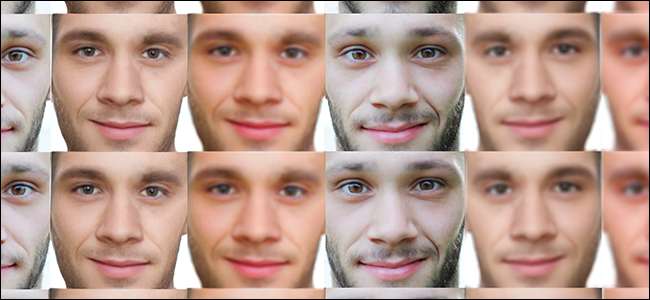

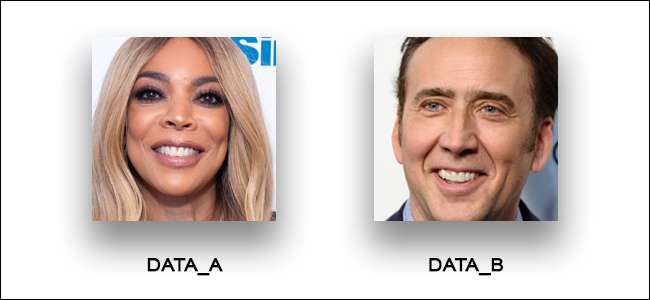

Hetzelfde geldt voor deepfake gezichtsrecreatie. Maar het opnieuw creëren van gezichten is natuurlijk niet hetzelfde als het verslaan van een videogame. Als we een deepfake zouden maken van Nicholas Cage als gastheer van de Wendy Williams-show, dan hebben we het volgende nodig:

- Een bestemmingsvideo : Vanaf nu werken deepfakes het beste met duidelijke, schone bestemmingsvideo's. Daarom zijn enkele van de meest overtuigende deepfakes van politici; ze hebben de neiging om bij constante verlichting stil te staan op een podium. Dus we hebben gewoon een video nodig van Wendy die stil zit en praat.

- Twee datasets : Om mond- en hoofdbewegingen er nauwkeurig uit te laten zien, hebben we een dataset van het gezicht van Wendy Williams en een dataset van het gezicht van Nicholas Cage nodig. Als Wendy naar rechts kijkt, hebben we een foto nodig van Nicholas Cage die naar rechts kijkt. Als Wendy haar mond opendoet, hebben we een foto nodig waarop Cage zijn mond opent.

Daarna laten we de AI zijn werk doen. Het probeert de deepfake keer op keer te creëren en leert gaandeweg van zijn fouten. Simpel toch? Welnu, een video van Cage's gezicht op het lichaam van Wendy William zal niemand voor de gek houden, dus hoe kunnen we een beetje verder gaan?

De meest overtuigende (en mogelijk schadelijke) deepfakes zijn totale nabootsingen. De populaire Obama deepfake door Jordan Peele is een goed voorbeeld. Laten we dus een van deze nabootsingen doen. Laten we een diepe vervalsing maken van Mark Zuckerberg die zijn mierenhaat verklaart - dat klinkt overtuigend, toch? Dit hebben we nodig:

- Een bestemmingsvideo : Dit kan een video zijn van Zuckerberg zelf of een acteur die op Zuckerberg lijkt. Als onze bestemmingsvideo van een acteur is, plakken we gewoon Zuckerbergs gezicht op de acteur.

- Fotogegevens : We hebben foto's nodig van Zuckerberg die praat, knippert en zijn hoofd beweegt. Als we zijn gezicht over een acteur heen leggen, hebben we ook een dataset nodig van de gezichtsbewegingen van de acteur.

- De stem van de Zuck : Onze deepfake moet klinken als The Zuck. We kunnen dit doen door een imitator op te nemen of door de stem van Zuckerberg opnieuw te creëren met AI. Om zijn stem opnieuw te creëren, laten we audiofragmenten van Zuckerberg gewoon door een AI-like lopen Liervogel en typ vervolgens wat we willen dat hij zegt.

- Een Lip-Sync AI : Sinds we zijn toevoegen de stem van nep-Zuckerberg in onze video, een lip-sync AI moet ervoor zorgen dat de deepfake gezichtsbewegingen overeenkomen met wat er wordt gezegd.

We proberen het werk en de expertise die in deepfakery zit niet te bagatelliseren. Maar in vergelijking met de CGI-baan van een miljoen dollar die dat opleverde Audrey Hepburn is terug uit de dood , deepfakes zijn een wandeling in het park. En hoewel we nog niet zijn gevallen voor een politieke of celebrity-deepfake, hebben zelfs de waardeloosste, meest voor de hand liggende deepfakes echte schade aangericht.

VERWANT: Het probleem met AI: machines leren dingen, maar kunnen ze niet begrijpen

Deepfakes hebben al echte schade aangericht

Vanaf nu zijn de meeste deepfakes alleen Nicholas Cage-memes, aankondigingen van openbare diensten en griezelige porno met beroemdheden. Deze verkooppunten zijn relatief onschadelijk en gemakkelijk te identificeren, maar in sommige gevallen worden deepfakes met succes gebruikt om verkeerde informatie te verspreiden en het leven van anderen te schaden.

In India worden deepfakes gebruikt door hindoe-nationalisten om vrouwelijke journalisten in diskrediet te brengen en aan te zetten tot geweld. In 2018 werd een journalist genoemd Rana Ayyub werd het slachtoffer op zo'n verkeerde informatiecampagne, die een deepfake-video van haar gezicht bevatte bovenop een pornografische video. Dit leidde tot andere vormen van online intimidatie en de dreiging met fysiek geweld .

In de Verenigde Staten wordt deepfake-technologie vaak gebruikt om niet-consensuele wraakporno te maken. Zoals gemeld door Vice , vroegen veel gebruikers van het nu verboden deepfakes Reddit-forum hoe ze deepfakes kunnen maken van ex-vriendinnen, crushes, vrienden en klasgenoten (ja, kinderporno). Het probleem is zo groot dat Virginia nu alle vormen van pornografie zonder wederzijds goedvinden verbiedt, inclusief deepfakes .

Naarmate deepfakes steeds overtuigender worden, zal de technologie ongetwijfeld voor meer dubieuze doeleinden worden gebruikt. Maar er is een kans dat we overdreven reageren, toch? Is dit niet de meest natuurlijke stap na Photoshop?

Deepfakes zijn een natuurlijke uitbreiding van bewerkte afbeeldingen

Zelfs op hun meest basale niveau zijn deepfakes verontrustend. We vertrouwen erop dat video- en audio-opnamen de woorden en daden van mensen vastleggen zonder vooringenomenheid of verkeerde informatie. Maar in zekere zin is de dreiging van deepfakes helemaal niet nieuw. Het bestaat al sinds we fotografie begonnen te gebruiken.

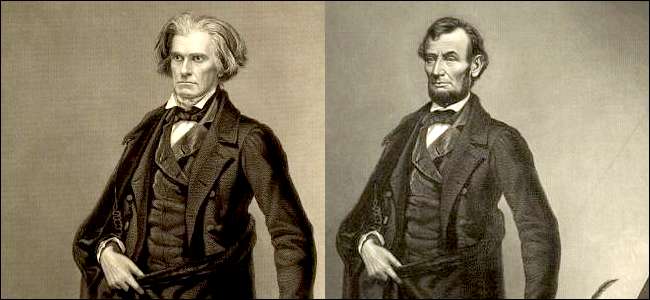

Neem bijvoorbeeld de weinige foto's die er zijn van Abraham Lincoln. Het merendeel van deze foto's (inclusief de portretten op de cent en het biljet van vijf dollar) werden gepromoveerd door een fotograaf genaamd Mathew Brady om Lincoln's spichtige uiterlijk te verbeteren (met name zijn dunne nek). Sommige van deze portretten zijn bewerkt op een manier die doet denken aan deepfakes, met Lincoln's hoofd bovenop de lichamen van 'sterke' mannen zoals Calhoun (het onderstaande voorbeeld is een ets, geen foto).

Dit klinkt als een bizar stukje publiciteit, maar tijdens de jaren 1860 droeg fotografie een zekere "waarheid" met zich mee die we nu reserveren voor video- en audio-opnamen. Het werd beschouwd als het tegenovergestelde van kunst - een wetenschap . Deze foto's zijn bewerkt om opzettelijk de kranten in diskrediet te brengen die Lincoln bekritiseerden vanwege zijn zwakke lichaam. Uiteindelijk werkte het. Amerikanen waren onder de indruk van Lincoln's figuur, en Lincoln zelf beweerde dat Brady's foto's " maakte me president .”

Het verband tussen deepfakes en fotobewerking uit de 19e eeuw is merkwaardig geruststellend. Het biedt ons het verhaal dat, hoewel deze technologie ernstige gevolgen heeft, het niet iets is dat we helemaal niet onder controle hebben. Maar helaas houdt dat verhaal misschien niet lang stand.

We zijn niet in staat om Deepfakes voor altijd te spotten

We zijn gewend om nepafbeeldingen en video's met onze ogen te zien. Het is gemakkelijk om naar een Joseph Goebbels familieportret en zeg , "Er is iets vreemds aan de hand met die man achterin." Een blik op Noord-Koreaanse propagandafoto's maakt duidelijk dat mensen zonder YouTube-tutorials slecht zijn in Photoshop. En zo indrukwekkend als deepfakes zijn, het is nog steeds mogelijk om een deepfake alleen te zien.

Maar we zullen niet veel langer deepfakes kunnen zien. Elk jaar worden deepfakes overtuigender en zelfs gemakkelijker te maken. Je kunt een deepfake maken met een enkele foto , en je kunt AI gebruiken zoals Liervogel om stemmen in minder dan een minuut te klonen. Hightech deepfakes die nepvideo en audio samenvoegen, zijn ongelooflijk overtuigend, zelfs als ze gemaakt zijn om herkenbare figuren te imiteren zoals Mark Zuckerberg .

In de toekomst kunnen we AI, algoritmen en blockchain-technologie gebruiken om deepfakes te bestrijden. Theoretisch zou AI video's kunnen scannen om te zoeken naar deepfake " vingerafdrukken , ”En blockchain-technologie die in verschillende besturingssystemen is geïnstalleerd, zou gebruikers of bestanden kunnen markeren die deepfake-software hebben aangeraakt.

Als deze anti-deepfake-methoden je stom in de oren klinken, word dan lid van de club. Even AI researchers betwijfelen of er een echte oplossing is voor deepfakes. Naarmate detectiesoftware beter wordt, zullen deepfakes dat ook doen. Uiteindelijk zullen we een punt bereiken waarop deepfakes onmogelijk te detecteren zijn, en we zullen ons veel meer zorgen maken dan nepporno van beroemdheden en video's van Nicolas Cage.