Vi har tendens til at stole på indholdet af video- og lydoptagelser. Men med AI kan alles ansigt eller stemme genskabes med nøjagtighed. Produktet er en dyb forfalskning, en efterligning, der kan bruges til memer, misinformation eller porno.

Et blik på Nicholas Cage dybe forfalskninger eller Jordan Peele deepfake PSA gør det klart, at vi har at gøre med mærkelig ny teknologi. Disse eksempler rejser spørgsmål om fremtiden, selvom de er relativt harmløse. Kan vi stole på video og lyd? Kan vi holde folk ansvarlige for deres handlinger på skærmen? Er vi klar til dybe forfalskninger?

Deepfakes er nye, nemme at lave og vokser hurtigt

Deepfake-teknologien er kun et par år gammel, men den er allerede eksploderet i noget, der er både fængslende og foruroligende. Udtrykket "deepfake", som blev opfundet på en Reddit-tråd i 2017, bruges til at beskrive genskabelsen af et menneskes udseende eller stemme gennem kunstig intelligens. Overraskende nok kan næsten enhver oprette en dyb forfalskning med en skør pc, noget software og et par timers arbejde.

Som med enhver ny teknologi er der en vis forvirring omkring deepfakes. Den "berusede Pelosi" -video er et glimrende eksempel på denne forvirring. Deepfakes er konstrueret af AI, og de er lavet til at efterligne mennesker. "Dunk Pelosi" -videoen, der er blevet omtalt som en dyb forfalskning, er faktisk bare en video af Nancy Pelosi, der har været bremset og korrigeret tonehøjde for at tilføje en sløret taleeffekt.

Dette er også det, der gør deepfakery anderledes end f.eks. CGI Carrie Fisher i Star Wars: Rogue One. Mens Disney brugte masser af penge på at studere Carrie Fishers ansigt og genskabe det i hånden, kan en nørd med noget dyb falsk software gør det samme job gratis på en enkelt dag. AI gør jobbet utroligt simpelt, billigt og overbevisende.

Sådan laver du en Deepfake

Ligesom en studerende i et klasseværelse er AI nødt til at "lære", hvordan man udfører den tilsigtede opgave. Det gør det gennem en proces med brute-force trial and error, normalt kaldet maskinindlæring eller dyb læring . En AI, der f.eks. Er designet til at fuldføre det første niveau af Super Mario Bros, spiller spillet igen og igen, indtil det viser den bedste måde at vinde på. Den person, der designer AI, skal give nogle data for at få tingene i gang sammen med et par "regler", når tingene går galt undervejs. Bortset fra det gør AI alt arbejdet.

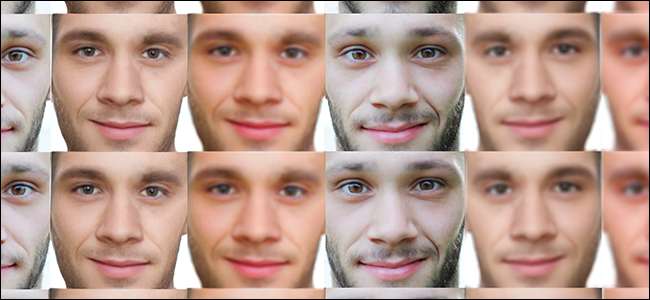

Det samme gælder for dybfalsk ansigtsrekreation. Men selvfølgelig er genskabelse af ansigter ikke det samme som at slå et videospil. Hvis vi skulle skabe en dyb forfalskning af Nicholas Cage, der var vært for Wendy Williams-showet, er det her, hvad vi har brug for:

- En destinationsvideo : Fra og med lige nu fungerer deepfakes bedst med klare, rene destinationsvideoer. Derfor er nogle af de mest overbevisende dybe forfalskninger politikere; de har tendens til at stå stille ved et podium under konstant belysning. Så vi har bare brug for en video af Wendy, der sidder stille og taler.

- To datasæt : For at mund- og hovedbevægelser kan se nøjagtige ud, har vi brug for et datasæt af Wendy Williams 'ansigt og et datasæt over Nicholas Cages ansigt. Hvis Wendy ser til højre, har vi brug for et billede af Nicholas Cage, der ser til højre. Hvis Wendy åbner munden, har vi brug for et billede af Cage, der åbner munden.

Derefter lader vi AI gøre sit job. Det forsøger at skabe dybfalsk igen og igen og lære af sine fejl undervejs. Simpelt, ikke? En video af Cages ansigt på Wendy Williams krop vil ikke narre nogen, så hvordan kan vi gå lidt længere?

De mest overbevisende (og potentielt skadelige) dybe forfalskninger er fuldstændige efterligninger. Det populære Obama dyb forfalskning af Jordan Peele er et godt eksempel. Så lad os gøre en af disse efterligninger. Lad os skabe en dyb forfalskning af Mark Zuckerberg, der erklærer sit had mod myrer - det lyder overbevisende, ikke? Her er hvad vi har brug for:

- En destinationsvideo : Dette kan være en video af Zuckerberg selv eller en skuespiller, der ligner Zuckerberg. Hvis vores destinationsvideo er af en skuespiller, indsætter vi simpelthen Zuckerbergs ansigt på skuespilleren.

- Fotodata : Vi har brug for billeder af Zuckerberg, der taler, blinker og bevæger hovedet rundt. Hvis vi overlejrer hans ansigt på en skuespiller, har vi også brug for et datasæt over skuespillerens ansigtsbevægelser.

- Zuck's Voice : Vores dybe forfalskning skal lyde som The Zuck. Vi kan gøre dette ved at optage en efterligning eller ved at genskabe Zuckerbergs stemme med AI. For at genskabe hans stemme kører vi simpelthen lydeksempler på Zuckerberg gennem en AI-lignende Lyrebird , og skriv derefter ud, hvad vi vil have ham til at sige.

- En Lip-Sync AI : Da vi er tilføjer stemmen til falsk Zuckerberg til vores video, en lip-sync AI skal sørge for, at de dybe falske ansigtsbevægelser matcher det, der bliver sagt.

Vi prøver ikke at bagatellisere det arbejde og den ekspertise, der ligger i deepfakery. Men sammenlignet med det million dollar CGI-job, der bragte Audrey Hepburn tilbage fra de døde , deepfakes er en tur i parken. Og mens vi endnu ikke er faldet for en politisk eller berømtheds dyb forfalskning, har selv de skøreste, mest åbenlyse dybe forfalskninger forårsaget reel skade.

RELATEREDE: Problemet med AI: Maskiner lærer ting, men kan ikke forstå dem

Deepfakes har allerede forårsaget skade fra den virkelige verden

Fra og med nu er størstedelen af dybe forfalskninger kun Nicholas Cage-memer, public service-meddelelser og uhyggelig berømthedsporno. Disse afsætningsmuligheder er relativt harmløse og lette at identificere, men i nogle tilfælde bruges dybe forfalskninger med succes til at sprede forkert information og skade andres liv.

I Indien anvendes dybe forfalskninger af hinduistiske nationalister til at miskreditere og tilskynde til vold mod kvindelige journalister. I 2018 hedder en journalist Rana Ayyub blev offer til en sådan misinformationskampagne, som indeholdt en dyb falsk video af hendes ansigt overlejret på en pornografisk video. Dette førte til andre former for onlinechikane og trussel om fysisk vold .

Stateside, deepfake-teknologi bruges ofte til at skabe ikke-konsensuel hævnporno. Som rapporteret af Vice , mange brugere på det nu forbudte deepfakes Reddit-forum spurgte, hvordan man kunne skabe deepfakes af ex-veninder, crushes, venner og klassekammerater (ja, børneporno). Problemet er så stort, at Virginia nu forbyr alle former for pornografi uden samtykke, inklusive dybe forfalskninger .

Når deepfakes bliver mere og mere overbevisende, vil teknologien utvivlsomt blive brugt til mere tvivlsomme formål. Men der er en chance for, at vi overreagerer, ikke? Er dette ikke det mest naturlige skridt efter Photoshop?

Deepfakes er en naturlig udvidelse af lægerede billeder

Selv på deres mest basale niveau er deepfakes foruroligende. Vi stoler på video- og lydoptagelser til at fange folks ord og handlinger uden nogen skævhed eller misinformation. Men på en måde er truslen om deepfakes slet ikke ny. Det har eksisteret, siden vi første gang begyndte at bruge fotografering.

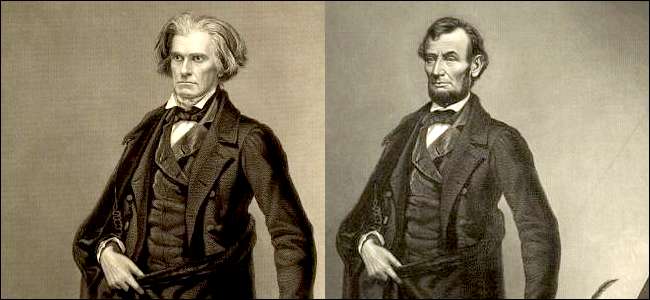

Tag for eksempel de få fotografier, der findes af Abraham Lincoln. Størstedelen af disse fotografier (inklusive portrætterne på øre og fem dollarsedlen) blev doktreret af en fotograf ved navn Mathew Brady for at forbedre Lincolns spindelige udseende (specifikt hans tynde hals). Nogle af disse portrætter blev redigeret på en måde, der minder om dybe forfalskninger, med Lincolns hoved lagt oven på kroppen af "stærke" mænd som Calhoun (eksemplet nedenfor er en ætsning, ikke et fotografi).

Dette lyder som en bizar reklame, men i 1860'erne bar fotografering en vis mængde "sandhed", som vi nu forbeholder til video- og lydoptagelser. Det blev anset for at være det modsatte af kunst - en videnskab . Disse fotos blev doktreret for at bevidst miskreditere de aviser, der kritiserede Lincoln for hans svage krop. I sidste ende fungerede det. Amerikanerne var imponeret over Lincolns figur, og Lincoln hævdede selv, at Bradys fotos “ gjorde mig til præsident .”

Forbindelsen mellem deepfakes og fotoredigering fra det 19. århundrede er underligt trøstende. Det giver os fortællingen, at selvom denne teknologi har alvorlige konsekvenser, er det ikke noget, der er helt uden for vores kontrol. Men desværre holder denne fortælling muligvis ikke meget længe.

Vi vil ikke være i stand til at få øje på Deepfakes for evigt

Vi er vant til at få øje på falske billeder og videoer. Det er let at se på en Joseph Goebbels familieportræt og sig , "Der er noget underligt ved den fyr i ryggen." Et blik på Nordkoreanske propagandafotos gør det tydeligt, at uden YouTube-tutorials suger folk i Photoshop. Og så imponerende som deepfakes er, det er stadig muligt at få øje på en dyb forfalskning alene ved synet.

Men vi vil ikke være i stand til at se dybe forfalskninger meget længere. Hvert år bliver deepfakes mere overbevisende og endnu lettere at skabe. Du kan lave en dyb forfalskning med et enkelt foto , og du kan bruge AI som Lyrebird at klone stemmer på under et minut. High-tech deepfakes, der fusionerer falsk video og lyd er utroligt overbevisende, selv når de er lavet til at efterligne genkendelige figurer som Mark Zuckerberg .

I fremtiden kan vi bruge AI, algoritmer og blockchain-teknologi til at bekæmpe deepfakes. Teoretisk kunne AI scanne videoer for at se efter dyb forfalskning “ fingeraftryk , ”Og blockchain-teknologi installeret på tværs af operativsystemer kunne markere brugere eller filer, der har rørt deepfake-software.

Hvis disse anti-dybfalske metoder lyder dumt for dig, så tilmeld dig klubben. Selv AI-forskere er i tvivl om, at der er en ægte løsning på dybe forfalskninger. Efterhånden som detekteringssoftware bliver bedre, vil deepfakes også blive. Til sidst når vi et punkt, hvor deepfakes vil være umulige at opdage, og vi har meget mere at bekymre os om end falsk berømthedsporno og Nicolas Cage-videoer.