คุณไม่ได้ต้องการเพียงแค่บทความหรือรูปภาพเท่านั้น แต่คุณต้องการ ทั้งหมด เว็บไซต์. วิธีใดเป็นวิธีที่ง่ายที่สุดในการสูบฉีดทั้งหมด

เซสชันคำถามและคำตอบของวันนี้มาถึงเราโดยได้รับความอนุเคราะห์จาก SuperUser ซึ่งเป็นแผนกย่อยของ Stack Exchange ซึ่งเป็นการรวมกลุ่มเว็บไซต์ถาม & ตอบโดยชุมชน

มีรูปภาพเป็นวอลล์เปเปอร์ที่ GoodFon .

คำถาม

ผู้อ่าน SuperUser Joe มีคำของ่ายๆ:

ฉันจะดาวน์โหลดหน้าทั้งหมดจากเว็บไซต์ได้อย่างไร?

แพลตฟอร์มใด ๆ ก็ดี

ทุกหน้าไม่มีข้อยกเว้น โจกำลังปฏิบัติภารกิจ

คำตอบ

ผู้สนับสนุน SuperUser Axxmasterr เสนอคำแนะนำแอปพลิเคชัน:

HTTRACK ทำงานเหมือนแชมป์ในการคัดลอกเนื้อหาของทั้งไซต์ เครื่องมือนี้สามารถจับชิ้นส่วนที่จำเป็นในการสร้างเว็บไซต์ที่มีเนื้อหาโค้ดที่ใช้งานอยู่ทำงานแบบออฟไลน์ได้ ฉันประหลาดใจกับสิ่งที่มันสามารถจำลองแบบออฟไลน์ได้

โปรแกรมนี้จะทำทุกอย่างที่คุณต้องการ

การล่าสัตว์ที่มีความสุข!

เราสามารถแนะนำ HTTRACK ได้อย่างเต็มที่ เป็นแอปพลิเคชันสำหรับผู้ใหญ่ที่ทำให้งานสำเร็จลุล่วง แล้วผู้เก็บถาวรบนแพลตฟอร์มที่ไม่ใช่ Windows ล่ะ? Jonik ผู้ให้ข้อมูลรายอื่นแนะนำเครื่องมือสำหรับผู้ใหญ่และทรงพลังอีกอย่าง

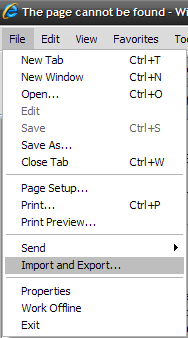

Wget เป็นเครื่องมือบรรทัดคำสั่งคลาสสิกสำหรับงานประเภทนี้ มาพร้อมกับระบบ Unix / Linux ส่วนใหญ่และคุณจะได้รับ สำหรับ Windows ด้วย (ใหม่กว่า 1.13.4 มีให้ที่นี่)

คุณต้องทำสิ่งต่อไปนี้

wget -r --no-parent http://site.com/songs/สำหรับรายละเอียดเพิ่มเติมโปรดดู คู่มือ Wget และมัน ตัวอย่าง หรือดูสิ่งเหล่านี้:

มีสิ่งที่จะเพิ่มคำอธิบาย? ปิดเสียงในความคิดเห็น ต้องการอ่านคำตอบเพิ่มเติมจากผู้ใช้ Stack Exchange ที่เชี่ยวชาญด้านเทคโนโลยีคนอื่น ๆ หรือไม่? ดูกระทู้สนทนาฉบับเต็มได้ที่นี่ .