Du vil ikke bare have en artikel eller et individuelt billede, du vil også have hel internet side. Hvad er den nemmeste måde at sifonere det hele på?

Dagens spørgsmål og svar-session kommer til os med tilladelse fra SuperUser - en underinddeling af Stack Exchange, en community-driven gruppe af Q&A websteder.

Billedet er tilgængeligt som tapet på GoodFon .

Spørgsmålet

SuperUser-læser Joe har en simpel anmodning:

Hvordan kan jeg downloade alle sider fra et websted?

Enhver platform er fint.

Hver side, ingen undtagelse. Joe er på mission.

Svaret

SuperUser-bidragyder Axxmasterr tilbyder en applikationsanbefaling:

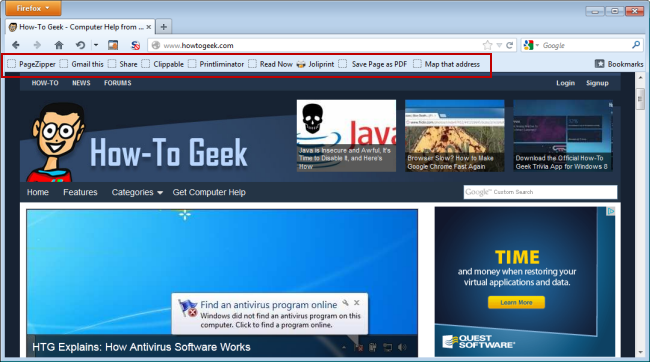

HTTRACK fungerer som en mester til at kopiere indholdet på et helt websted. Dette værktøj kan endda få fat i de stykker, der er nødvendige for at få et websted med aktiv kodeindhold til at fungere offline. Jeg er forbløffet over de ting, det kan replikere offline.

Dette program gør alt hvad du behøver af det.

God jagt!

Vi kan varmt anbefale HTTRACK. Det er en moden applikation, der får jobbet gjort. Hvad med arkivister på ikke-Windows-platforme? En anden bidragyder, Jonik, foreslår et andet modent og kraftfuldt værktøj:

Wget er et klassisk kommandolinjeværktøj til denne form for opgave. Den leveres med de fleste Unix / Linux-systemer, og du kan få det Til Windows også (nyere 1.13.4 tilgængelig her).

Du ville gøre noget som:

wget -r - ingen forælder http://site.com/songs/For flere detaljer, se Wget Manual ogdet er eksempler , eller se på disse:

Har du noget at tilføje til forklaringen? Lyder i kommentarerne. Vil du læse flere svar fra andre teknisk kyndige Stack Exchange-brugere? Tjek den fulde diskussionstråd her .