기사 나 개별 이미지 만 원하는 것이 아니라 전부의 웹 사이트. 모든 것을 빨아들이는 가장 쉬운 방법은 무엇입니까?

오늘의 질문 및 답변 세션은 커뮤니티 중심의 Q & A 웹 사이트 그룹 인 Stack Exchange의 하위 부문 인 SuperUser가 제공 한 것입니다.

바탕 화면으로 제공되는 이미지 GoodFon .

질문

수퍼 유저 리더 Joe는 간단한 요청을합니다.

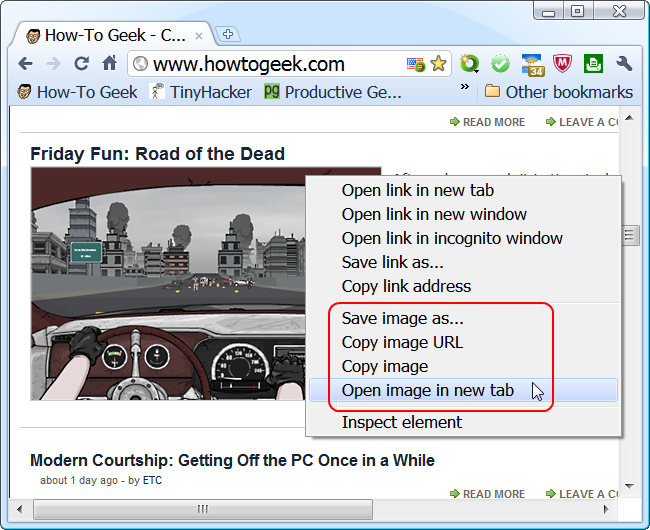

웹 사이트에서 모든 페이지를 다운로드하려면 어떻게해야합니까?

모든 플랫폼이 좋습니다.

모든 페이지, 예외는 없습니다. Joe는 임무를 수행하고 있습니다.

대답

수퍼 유저 기고자 Axxmasterr는 응용 프로그램 권장 사항을 제공합니다.

HTTRACK은 전체 사이트의 콘텐츠를 복사하는 챔피언처럼 작동합니다. 이 도구는 활성 코드 콘텐츠가있는 웹 사이트를 오프라인에서 작동시키는 데 필요한 부분을 가져올 수도 있습니다. 오프라인에서 복제 할 수있는 기능에 놀랐습니다.

이 프로그램은 필요한 모든 작업을 수행합니다.

즐거운 사냥!

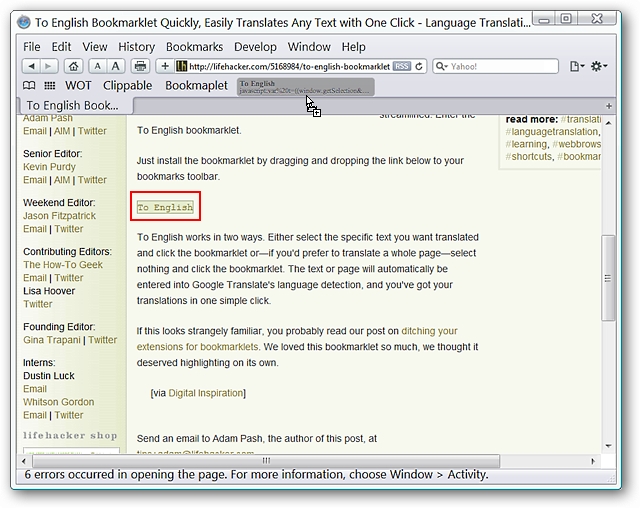

HTTRACK을 진심으로 추천 할 수 있습니다. 작업을 완료하는 성숙한 응용 프로그램입니다. Windows가 아닌 플랫폼의 아카이브 담당자는 어떻습니까? 또 다른 기여자 인 Jonik은 또 다른 성숙하고 강력한 도구를 제안합니다.

Wget 이러한 종류의 작업을위한 고전적인 명령 줄 도구입니다. 대부분의 Unix / Linux 시스템과 함께 제공되며 얻을 수 있습니다. Windows 용 너무 (최신 1.13.4 여기에서 사용 가능).

다음과 같이 할 수 있습니다.

wget -r --no-parent http://site.com/songs/

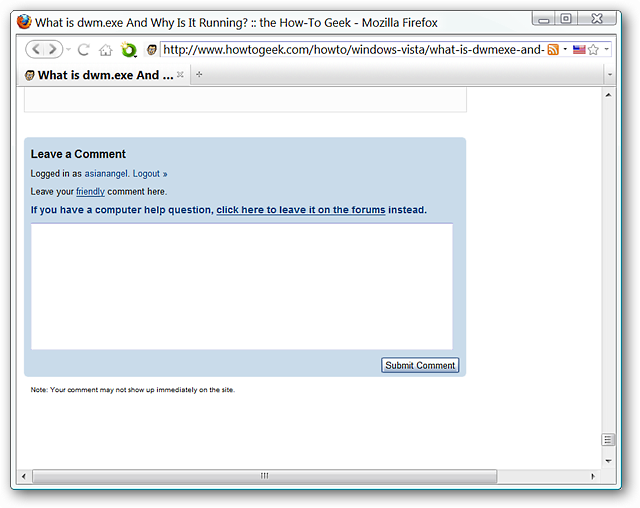

설명에 추가 할 것이 있습니까? 댓글에서 소리를 내세요. 기술에 정통한 다른 Stack Exchange 사용자의 답변을 더 읽고 싶으신가요? 여기에서 전체 토론 스레드를 확인하십시오. .