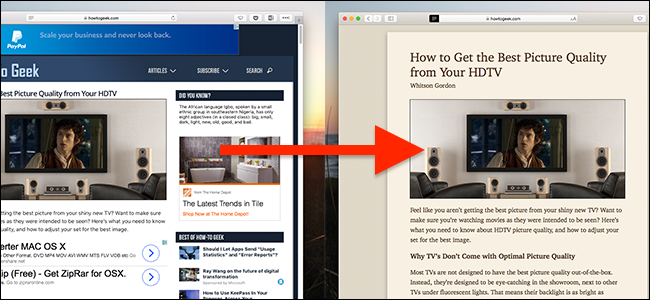

Du vil ikke bare ha en artikkel eller et individuelt bilde, du vil ha det hel nettsted. Hva er den enkleste måten å sifonere det hele på?

Dagens spørsmål og svar-økt kommer til oss med tillatelse fra SuperUser - en underavdeling av Stack Exchange, en samfunnsdrevet gruppe av spørsmål og svar-nettsteder.

Bildet er tilgjengelig som bakgrunn på GoodFon .

Spørsmålet

SuperUser-leser Joe har en enkel forespørsel:

Hvordan kan jeg laste ned alle sider fra et nettsted?

Enhver plattform er bra.

Hver side, ikke noe unntak. Joe er på oppdrag.

Svaret

SuperUser-bidragsyter Axxmasterr tilbyr en applikasjonsanbefaling:

HTTRACK fungerer som en mester for å kopiere innholdet på et helt nettsted. Dette verktøyet kan til og med ta tak i bitene som trengs for å få et nettsted med aktiv kodeinnhold til å fungere offline. Jeg er overrasket over tingene den kan replikere offline.

Dette programmet vil gjøre alt du trenger av det.

God jakt!

Vi kan hjertelig anbefale HTTRACK. Det er en moden applikasjon som får jobben gjort. Hva med arkivister på ikke-Windows-plattformer? En annen bidragsyter, Jonik, foreslår et annet modent og kraftig verktøy:

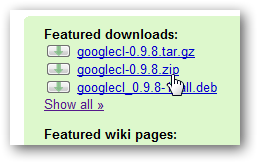

Wget er et klassisk kommandolinjeverktøy for denne typen oppgaver. Den kommer med de fleste Unix / Linux-systemer, og du kan få den for Windows også (nyere 1.13.4 tilgjengelig her).

Du vil gjøre noe sånt som:

wget -r --no-parent http://site.com/songs/For mer informasjon, se Wget Manual og dets eksempler , eller ta en titt på disse:

Har du noe å legge til forklaringen? Hør av i kommentarene. Vil du lese flere svar fra andre teknologikyndige Stack Exchange-brukere? Sjekk ut hele diskusjonstråden her .