Superdatamaskiner var et massivt løp på 90-tallet, da USA, Kina og andre alle konkurrerte om å få den raskeste datamaskinen. Mens løpet har dødd litt ut, brukte disse monster-datamaskinene fortsatt å løse mange av verdens problemer.

Som Moores lov (en gammel observasjon som sier at datakraft dobler omtrent hvert annet år) skyver databehandlingsmaskinvaren vår videre, og kompleksiteten til problemene som løses øker også. Mens superdatamaskiner pleide å være rimelig små, kan de i dag ta opp hele lagre, alle fylt opp med sammenkoblede datamaskinstativ.

Hva gjør en datamaskin “super”?

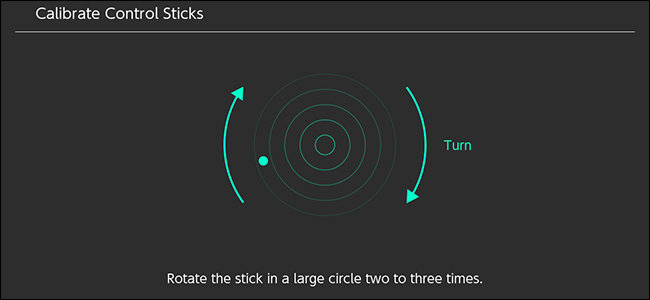

Begrepet "Supercomputer" innebærer en gigantisk datamaskin mange ganger kraftigere enn den enkle bærbare datamaskinen din, men det kan ikke være lenger fra saken. Superdatamaskiner består av tusenvis av mindre datamaskiner, alle koblet sammen for å utføre en oppgave. Hver CPU-kjerne i et datasenter går sannsynligvis tregere enn din stasjonære datamaskin. Det er kombinasjonen av dem alle som gjør databehandling så effektiv. Det er mye nettverk og spesiell maskinvare involvert i datamaskiner i denne skalaen, og det er ikke så enkelt som å bare koble hvert stativ til nettverket, men du kan se for deg på denne måten, og du vil ikke være langt utenfor merket.

Ikke alle oppgaver kan parallelliseres så lett, så du bruker ikke en superdatamaskin til å kjøre spillene dine med en million bilder per sekund. Parallell databehandling er vanligvis god til å fremskynde veldig beregningsorientert databehandling.

Superdatamaskiner måles i FLOPS, eller Floating Point Operations Per Second, som egentlig er et mål på hvor raskt det kan matte. Den raskeste for tiden er IBMs toppmøte , som kan nå over 200 PetaFLOPS, en million ganger raskere enn “Giga” folk flest er vant til.

Så hva brukes de til? For det meste vitenskap

Superdatamaskiner er ryggraden i beregningsvitenskapen. De brukes innen det medisinske feltet til å kjøre proteinfoldingssimuleringer for kreftforskning, i fysikk for å kjøre simuleringer for store ingeniørprosjekter og teoretisk beregning, og til og med på det økonomiske feltet for å spore aksjemarkedet for å få et forsprang på andre investorer.

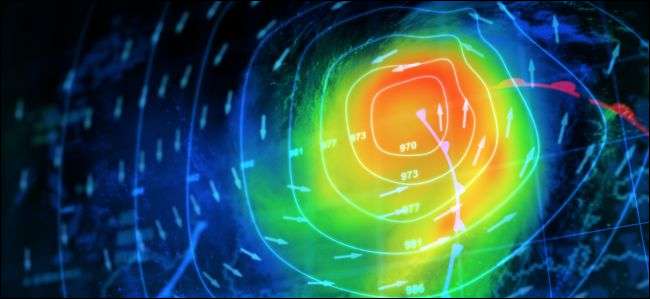

Kanskje jobben som er mest fordelaktig for den gjennomsnittlige personen er værmodellering. Å forutsi nøyaktig om du trenger en kappe og en paraply neste onsdag er en overraskende vanskelig oppgave, en selv de gigantiske superdatamaskinene i dag ikke kan gjøre med stor nøyaktighet. Det er teoretisert at vi for å kunne kjøre fullværsmodellering trenger en datamaskin som måler hastigheten i ZettaFLOPS - ytterligere to nivåer opp fra PetaFLOPS og rundt 5000 ganger raskere enn IBMs Summit. Vi kommer sannsynligvis ikke til å treffe det punktet før 2030, selv om hovedproblemet som holder oss tilbake ikke er maskinvaren, men kostnaden.

Forhåndskostnaden for å kjøpe eller bygge all den maskinvaren er høy nok, men den virkelige kickeren er strømregningen. Mange superdatamaskiner kan bruke strøm på millioner av dollar hvert år bare for å fortsette å kjøre. Så selv om det teoretisk sett ikke er noen grense for hvor mange bygninger fulle av datamaskiner du kan koble sammen, bygger vi bare superdatamaskiner som er store nok til å løse aktuelle problemer.

Så vil jeg ha en superdatamaskin hjemme i fremtiden?

På en måte gjør du det allerede. De fleste stasjonære datamaskiner konkurrerer i dag med kraften til eldre superdatamaskiner, med til og med den gjennomsnittlige smarttelefonen som har høyere ytelse enn den beryktede Cray-1 . Så det er enkelt å sammenligne fortiden og teoretisere om fremtiden. Men det skyldes i stor grad at gjennomsnittlig CPU har blitt mye raskere gjennom årene, noe som ikke skjer like raskt lenger.

I det siste har Moores lov avtatt når vi når grensene for hvor små vi kan lage transistorer, slik at CPU-er ikke blir mye raskere. De blir mindre og mer strømeffektive, noe som skyver CPU-ytelsen i retning av flere kjerner per chip for stasjonære datamaskiner og kraftigere generelt for mobile enheter.

Men det er vanskelig å se for seg at gjennomsnittsbrukerens problem gir voksende databehov. Tross alt trenger du ikke en superdatamaskin for å surfe på Internett, og de fleste kjører ikke protein-folding-simuleringer i kjellerne. Dagens high-end maskinvare for forbruker overgår langt fra normale bruksområder og er vanligvis reservert for spesifikt arbeid som drar nytte av det, som 3D-gjengivelse og kodekompilering.

Så nei, du vil sannsynligvis ikke ha en. De største fremskrittene vil trolig være i mobilområdet, som telefoner og nettbrett nærme deg skrivebordets kraftnivåer , som fremdeles er en ganske god fremgang.

Bildekreditter: Shutterstock , Shutterstock