RAM-moduler er billigere end nogensinde før, så hvorfor kører vi ikke hele vores operativsystem fra superhurtige RAM-banker?

Dagens spørgsmål og svar-session kommer til os med tilladelse fra SuperUser - en underinddeling af Stack Exchange, en community-driven gruppe af Q&A websteder.

Spørgsmålet

SuperUser-læser pkr298 vil vide, hvorfor vi ikke kører RAM-baserede i stedet for diskbaserede maskiner. Han skriver:

RAM er billigt og meget hurtigere end SSD'er. Det er bare ustabilt. Så hvorfor har computere ikke MEGET RAM, og når de tændes, skal du indlæse alt til RAM fra harddisken / SSD og bare køre alt derfra, forudsat at der ikke er noget reelt behov for at vedvare noget uden for hukommelsen? Ville computere ikke være meget hurtigere?

Det nuværende operativsystem understøtter muligvis slet ikke dette, men er der nogen grund til, at RAM ikke bruges på denne måde?

På overfladen giver hans henvendelse mening, men vi er tydeligvis ikke oversvømmede i RAM-baserede computerbygninger; hvad er baghistorien?

Svaret

SuperUser-bidragyder Hennes giver et indblik i, hvorfor vi stadig bruger diskbaserede systemer:

Der er et par grunde til, at RAM ikke bruges på den måde:

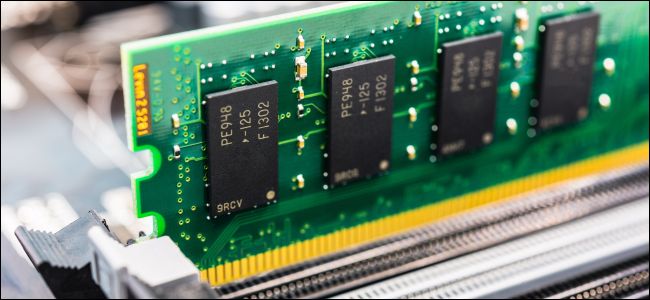

- Fælles desktop (DDR3) RAM er billigt, men ikke så billigt. Især hvis du vil købe relativt store DIMM-moduler.

- RAM mister sit indhold, når det slukkes. Således skal du genindlæse indholdet ved opstartstidspunktet. Sig, at du bruger en SSD-størrelse RAMDISK på 100 GB, det betyder cirka to minutters forsinkelse, mens 100 GB kopieres fra disken.

- RAM bruger mere strøm (siger 2-3 Watt pr. DIMM, omtrent det samme som en inaktiv SSD).

- For at bruge så meget RAM har dit bundkort brug for mange DIMM-stik og sporene til dem. Normalt er dette begrænset til seks eller derunder. (Mere bordplads betyder flere omkostninger og dermed højere priser.)

- Endelig skal du også bruge RAM til at køre dine programmer i, så du skal bruge den normale RAM-størrelse til at arbejde i (f.eks. 18 GHz og nok til at gemme de data, du forventer at bruge).

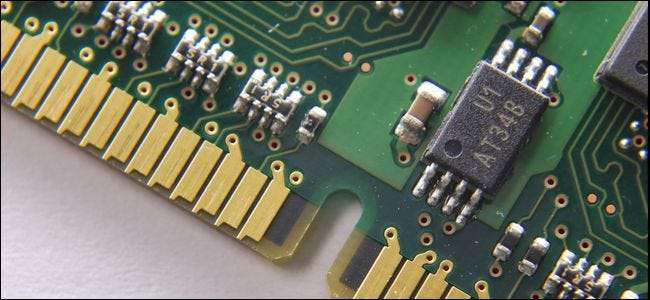

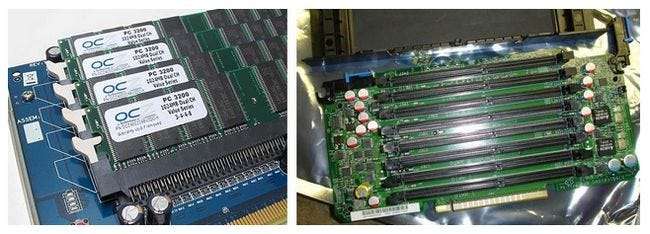

Når det er sagt: Ja, der findes RAM-diske. Selvom PCI-kort med DIMM-stik og som apparater til meget høje IOps. (Mest brugt i virksomhedsdatabaser, før SSD'er blev en mulighed). Disse ting er ikke billigt selvom.

Her er to eksempler på low-end RAM-diskkort, der gjorde det til produktion:

Bemærk, at der er langt flere måder at gøre dette på end blot ved at oprette en RAM-disk i den fælles arbejdshukommelse.

Du kan:

- Brug et dedikeret fysisk drev til det med flygtig (dynamisk) hukommelse. Enten som et apparat eller med et SAS-, SATA- eller PCI[e]-interface.

- Du kan gøre det samme med batteribagret opbevaring (det er ikke nødvendigt at kopiere indledende data til det, da det bevarer dets indhold, så længe backup-strømmen forbliver gyldig).

- Du kan bruge statiske RAM'er i stedet for DRAMS (enklere, dyrere).

- Du kan bruge flash eller anden permanent lagring til at gemme alle data (Advarsel: flash har normalt et begrænset antal skrivecyklusser). Hvis du bruger flash som kun lagerplads, flyttede du lige til SSD'er. Hvis du gemmer alt i dynamisk RAM og gemmer til flash-backup ved slukning, gik du tilbage til apparater.

Jeg er sikker på, at der er meget mere at beskrive, fra Amiga RAD: nulstil overlevende RAM-diske til IOPS, slidudjævning og G-d ved hvad, men jeg vil klippe dette kort og kun nævne endnu et element:

DDR3 (nuværende DRAM) priser versus SSD priser:

- DDR3: 10 € pr. GiB eller 10.000 € pr. TiB

- SSD'er: Betydeligt mindre. (Omkring 1/4 til 1/10.)

Hvis du vil læse mere om RAM-diske, skal du tjekke ud RAM-diske forklaret: Hvad de er, og hvorfor du sandsynligvis ikke skal bruge en .

Har du noget at tilføje til forklaringen? Lyder i kommentarerne. Vil du læse flere svar fra andre teknisk kyndige Stack Exchange-brugere? Tjek den fulde diskussionstråd her .